机器之心编译

脉冲神经网络(SNN)属于第三代神经网络模型,完成了更初级的生物神经模仿程度。除了神经元和突触形态之外,SNN 还将工夫概念归入了其操作之中。本文将扼要引见这种奥秘的神经网络方式。

一切对目前 机器学习 有所理解的人都听说过这样一个现实:目前的人工神经网络是第二代神经网络。它们通常是全衔接的,接纳延续的值,输入延续的值。 虽然当代神经网络曾经让我们在很多范畴中完成了打破,但它们在生物学上是不准确的,其实并不能模拟生物大脑神经元的运作机制。

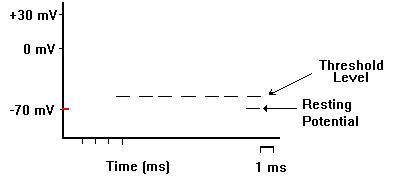

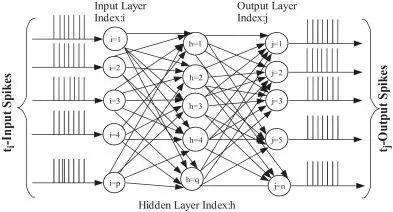

第三代神经网络,脉冲神经网络(Spiking Neural Network,SNN),旨在弥合神经迷信和机器学习之间的差距,运用最拟合生物神经元机制的模型来停止计算。脉冲神经网络与目前盛行的神经网络和机器学习办法有着基本上的不同。SNN 运用脉冲——这是一种发作在工夫点上的团圆事情——而十分见的延续值。每个峰值由代表生物进程的微分方程表示出来,其中最重要的是神经元的膜电位。实质上,一旦神经元到达了某一电位,脉冲就会呈现,随后到达电位的神经元会被重置。对此,最罕见的模型是 Integrate-And-Fire(LIF)模型。此外,SNN 通常是稀疏衔接的,并会应用特殊的网络拓扑。

LIF 模型中膜电位的微分方程

脉冲时期的膜电位形状

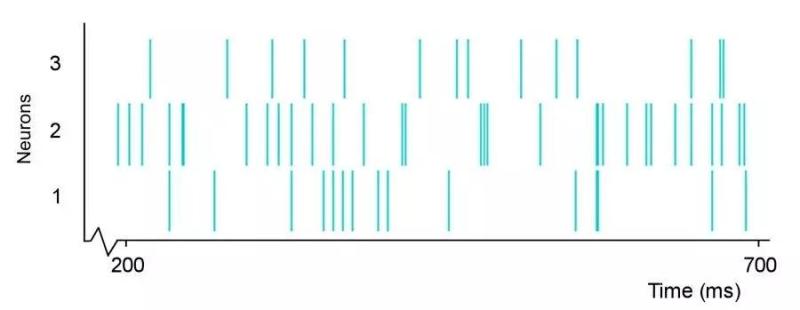

三神经元网络的脉冲训练

脉冲神经网络图示

乍一看,脉冲神经网络的办法像是一种发展。我们从延续输入挪动至二进制输入,这些脉冲训练的可解释性不强。但是,脉冲训练加强了我们处置时空数据(或许说真实世界感官数据)的才能。空间指神经元仅与左近的神经元衔接,这样它们可以辨别处置输出块(相似于 CNN 运用滤波器)。工夫指脉冲训练随着工夫而发作,这样我们在二进制编码中丧失的信息可以在脉冲的工夫信息中重新获取。这允许我们自然地处置工夫数据,无需 RNN 添加额定的复杂度。现实证明脉冲神经元是比传统人工神经元更弱小的计算单元。

既然实际上 SNN 比第二代网络更弱小,那么我们很自然会想到为什么它们没有失掉普遍使用。次要成绩在于 SNN 的训练。虽然我们有无监视生物学习办法,如赫布学习(Hebbian learning)和 STDP,但没有合适 SNN 的无效监视训练办法可以 i 经过提供优于第二代网络的功能。由于脉冲训练不可微,我们无法在不损失精确工夫信息的前提下运用梯度下降来训练 SNN。因而,为了正确地运用 SNN 处理真实世界义务,我们需求开发一种高效的监视学习办法。这是一项艰难的义务,由于它触及到,给定这些网络的生物理想主义,确定人类大脑如何学习。

另一个成绩是在正常硬件上模仿 SNN 需求消耗少量算力,由于它需求模仿微分方程。但是,神经形状硬件,如 IBM TrueNorth,旨在运用应用神经元脉冲行为的团圆和稀疏实质的专门硬件模仿神经元,进而处理该成绩。

明天看来,SNN 的将来仍然不甚明晰。一方面,它们是我们以后神经网络的自然承继者;但是另一方面,对大少数义务来说它们还远不是理论工具。目前在实时图像和音频处置中有一些 SNN 实践使用,但相关文献依然很少。绝大少数 SNN 论文或许是实际的,或许在一个复杂的全衔接第二代网络之中展现功能。但是,很多团队正努力于开发 SNN 监视式学习规则,并且我对 SNN 的将来充溢悲观。

原文链接:https://towardsdatascience.com/spiking-neural-networks-the-next-generation-of-machine-learning-84e167f4eb2b

大众号:机器之心