文/陈光

微信大众号/自动驾驶干货铺

前言

上一次的分享里,我引见了GPS+IMU这组黄金伙伴,这两个传感器的组合可以完成城区路途 自动驾驶 的波动定位功用,处理了第一个大成绩“我”在哪的成绩。

为了能让无人车能像人一样,遇到妨碍物或红灯就加速,直到中止;遇到绿灯或后方无妨碍物的状况,停止减速等操作。这就需求车载传感器去四周的环境停止感知。

使用于无人车上的传感器目前有四大类,辨别是摄像机,激光雷达、毫米波雷达和超声波雷达。不同的传感器依据其传感特性,布置在车身的不同地位。

明天我以百度Apollo 2.0开放的摄像头及其模块作为引子,对无人车上的摄像机停止详细引见。

下图就是百度Apollo 2.0引荐运用的摄像机LI-USB30-AR023ZWDR。Apollo 2.0中运用了两个异样的摄像机,经过USB3.0的转接线接入控制器,传递黑色图像信息。两个摄像机的镜头的焦距辨别是6mm和25mm,辨别用于检测近处和远处的红绿灯。

注释

摄像机的分类

摄像机依据镜头和布置方式的不同次要有以下四种:单目摄像机、双目摄像机、三目摄像机和环顾摄像机。

单目摄像机

单目摄像机模组只包括一个摄像机和一个镜头。

由于很多图像算法的研讨都是基于单目摄像机开发的,因而绝对于其他类别的摄像机,单目摄像机的算法成熟度更高。

但是单目有着两个后天的缺陷。

一是它的视野完全取决于镜头。

焦距短的镜头,视野广,但缺失远处的信息。反之亦然。因而单目摄像机普通选用适中焦距的镜头。

二是单目测距的精度较低。

摄像机的成像图是透视图,即越远的物体成像越小。近处的物体,需求用几百甚至上千个像素点描绘;而处于远处的同一物体,能够只需求几个像素点即可描绘出来。这种特性会招致,越远的中央,一个像素点代表的间隔越大,因而对单目来说物体越远,测距的精度越低。

双目摄像机

由于单目测距存在缺陷,双目摄像机应运而生。

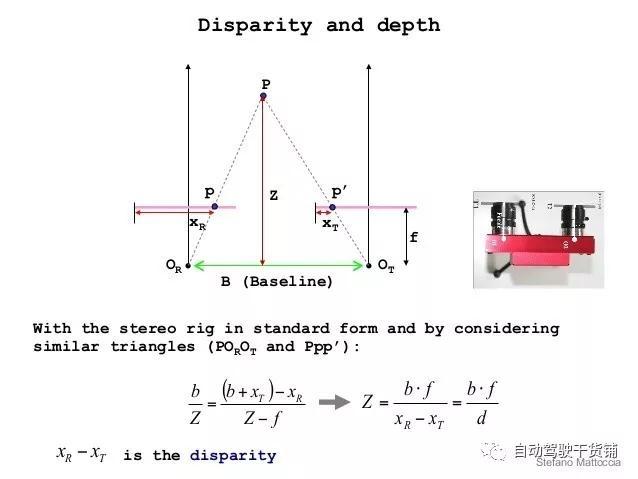

相近的两个摄像机拍摄物体时,会失掉同一物体在摄像机的成像立体的像素偏移量。有了像素偏移量、相机焦距和两个摄像机的实践间隔这些信息,依据数学换算即可失掉物体的间隔。原理图下图。

图片出处:https://www.slideshare.net/DngNguyn43/stereo-vision-42147593

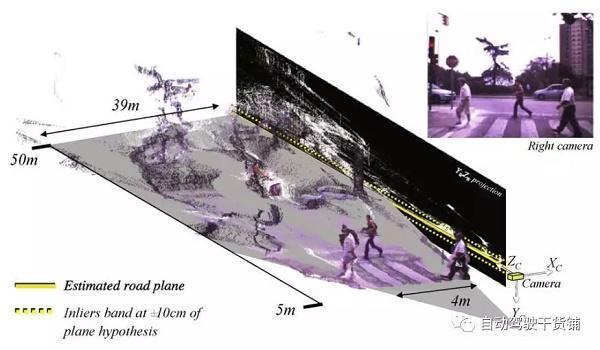

依据双目测距原理使用在图像上每一个像素点时,即可失掉图像的深度信息,如下图。

图片出处:《2D-3D-based on-board pedestrian detection system》

深度信息的参加,不只能便于妨碍物的分类,更能进步高精度地图定位婚配的精度。

虽然双目能失掉较高精度的测距后果和提供图像联系的才能,但是它与单目一样,镜头的视野完全依赖于镜头。而且双目测距原理对两个镜头的装置地位和间隔要求较多,这就会给相机的标定带来费事。

三目摄像机

由于单目和双目都存在某些缺陷,因而普遍使用于无人驾驶的摄像机方案为三目摄像机。三目摄像机其实就是三个不同焦距单目摄像机的组合。

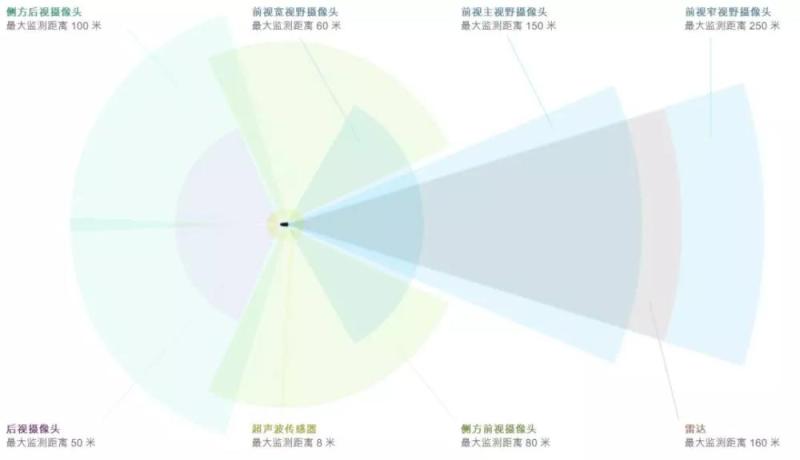

下图为特斯拉 AutoPilot 2.0装置在挡风玻璃下方的三目摄像机。

依据焦距不同,每个摄像机所感知的范围也不尽相反。

如下图,可以看出三个摄像头的感知范围由远及近,辨别为前视窄视野摄像头(最远感知250米)、前视主视野摄像头(最远感知150米)及前视宽视野摄像头(最远感知60米)。

对摄像机来说,感知的范围要么损失视野,要么损失间隔。三目摄像机能较好地补偿感知范围的成绩。因而在业界被普遍使用。

那么测距精度的成绩怎样办?

正是由于三目摄像机每个相机的视野不同,因而近处的测距交给宽视野摄像头,中间隔的测距交给主视野摄像头,更远的测距交给窄视野摄像头。这样一来每个摄像机都能发扬其最大优势。

三目的缺陷是需求同时标定三个摄像机,因此任务量更大一些。其次软件局部需求关联三个摄像机的数据,对算法要求也很高。

环顾摄像机

之前提到的三款摄像机它们所用的镜头都是非鱼眼的,环顾摄像机的镜头是鱼眼镜头,而且装置地位是朝向空中的。某些高配车型上会有“360°全景显示”功用,所用到的就是环顾摄像机。

装置于车辆后方、车辆左右后视镜下和车辆前方的四个鱼眼镜头采集图像,采集到的图像与下图相似。鱼眼摄像机为了获取足够大的视野,代价是图像的畸变严重。

经过标定值,停止图像的投影变换,可将图像复原成仰望图的样子。之后对四个方向的图像停止拼接,再在四幅图像的两头放上一张车的仰望图,即可完成从车顶往下看的效果。如下图。

环顾摄像机的感知范围并不大,次要用于车身5~10米内的妨碍物检测、自主泊车时的库位线辨认等。

摄像机的功用

摄像机在无人车上的使用,次要有两大类功用。辨别是感知才能,其次是定位才能。

感知才能

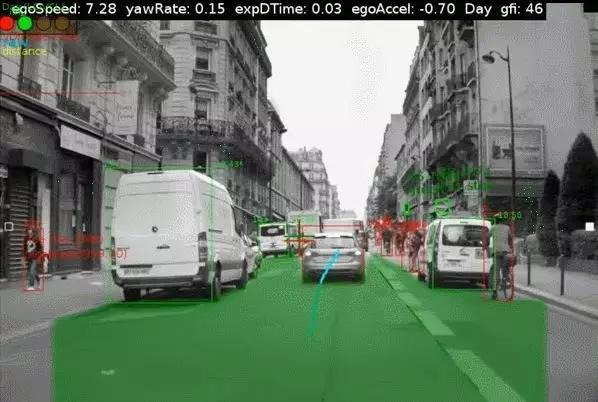

在无人驾驶范畴,摄像机的次要功用是完成各种环境信息的感知。接上去我会以Mobileye(一家国际上功用做视觉最牛的公司)为例引见摄像机可以完成的功用。先看两张图,视频可以拖拽到最初点击“阅读全文”。

可以看出摄像机可以提供的感知才能有:

①车道线(lane)

图中的深绿色线。车道线是摄像机可以感知的最根本的信息,拥有车道线检测功用即可完成高速公路的车道坚持功用。

②妨碍物(Obstacle)

图中运用矩形框框中的物体。图中仅有汽车、行人和自行车等物体。其实妨碍物的品种可以更丰厚,比方摩托车、卡车,甚至植物都是可以检测到的。有了妨碍物信息,无人车即可完成车道内的跟车行驶。

③交通标志牌和空中标志(Traffic Sign and Road Sign)

图中运用绿色或白色矩形框框出的物体。这些感知信息更多的是作为路途特征与高精度地图做婚配后,辅佐定位。当然也可以基于这些感知后果停止地图的更新。

④可通行空间(FreeSpace)

图中运用通明绿的掩盖的区域。该区域表示无人车可以正常行使的区域。可通行空间可以让车辆不再局限于车道内行驶,完成更多跨车道的超车功用等,把车开的更像老司机。

⑤交通讯号灯(Traffic Light)

图中运用绿框框出来的物体。交通讯号灯形态的感知才能关于城区行驶的无人驾驶汽车非常重要,这也是为什么百度Apollo 2.0完成“复杂路况自动驾驶”所必需开放的功用。

定位才能

置信大家都对视觉SLAM技术都有所耳闻,依据提早建好的地图和实时的感知后果做婚配,获取以后无人车的地位。视觉SLAM需求处理的最大成绩在于地图的容量过大,略微大一点的区域,就对硬盘的容量要求很高。如何制造出足够轻量化的地图,成为SLAM技术商业化的关键。

Mobileye在已完成的路途经历管理(Road Experience Management,REM)功用,可以完成复杂路况的全局定位才能。如下图。

看个视频感受一下。

小结

目前百度Apollo 2.0仅开放了摄像机的交通讯号灯检测才能,妨碍物的感知还是激烈依赖于激光雷达和毫米波雷达。置信在将来,文章中引见的这些功用都会渐渐开放的。

摄像机是一切车载传感器中,感知才能最强的,没有之一。这也是为什么特斯拉采用了纯视觉的感知方案,而坚持不运用激光雷达的缘由(当然激光雷达贵也是一个要素)。

好了(^o^)/~,这篇分享根本上让大家理解了无人车所运用到的视觉感知技术。

假如您觉得有播种,希望您能把文章分享给更多的人。这是我继续更新文章的最大动力。

感激(・ω・)ノ!