▷每周精选一篇油管频道 Arxiv Insights 视频

翻译 | 刘斌 校正 | 余杭 整理 | 张翼飞

雷锋网按:AlphaGo和AlphaGo Zero傻傻分不清楚?明天雷锋网独家译制视频How AlphaGo Zero works 带大家回忆AlphaGo Zero的五大亮点。

相比以前的阿法狗版本,AlphaGo Zero完全自主训练。这意味着不需求应用人类专业选手的下棋数据,它直接经过围棋对弈停止学习。

以前的办法选用了少量人工定义的围棋特征,新的办法没有选用这些特征,而是直接从棋盘形态中停止学习。

这篇论文从规范的卷集神经网络转向了残差网络,笔者以为是Resnet.网络。

这个网络从原有的两个不同的战略网络和评价网络改为组分解一个网络,这个网络完成了原有两个网络的功用。

新版本保持了蒙特卡罗办法,改为采用复杂的两阶段搜索办法,并将这种办法使用于这个网络上,停止场面预测和停止无效的下子。

不必围棋特征,直接在下棋中学习

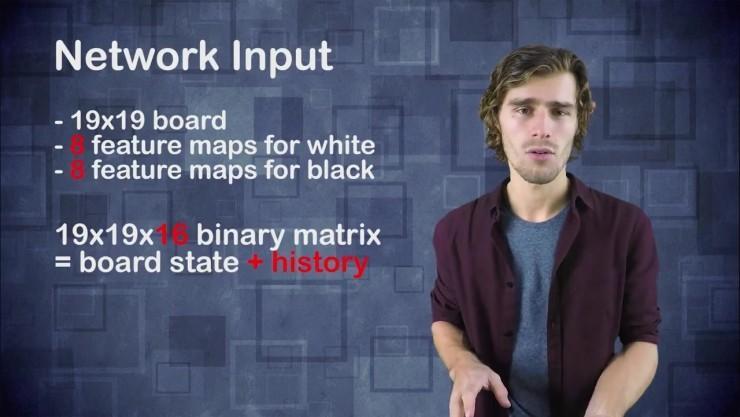

首先,我们先引见一下围棋中的棋盘地位。棋盘由19*19的方格组成,这样就有19*19个地位,每个地位上可以放置白子,也可以放黑子,还可以什么都不放。DeepMind团队创立了一个独自的特征映射,这个映射关于黑子和白子都是独自创立的,这就意味着关于棋盘上一切的白子会失掉19*19的二进制矩阵。

假如地位上有白子 矩阵对应的元素是1;假如棋盘地位上没有白子 对应矩阵元素就是0。黑子的映射矩阵,也是异样的后果。假如棋盘地位上有黑子,对应矩阵元素是1。假如没有黑子,对应矩阵元素是0。

这样这两个矩阵就表示了以后的棋盘地位,异样AlphaGo Zero这篇论文引入了其他特征面来表示,过来的7步的棋盘形态以便可以将棋盘的过来形态引入。

不再用规范卷积构造,采用残差网络

新版本的AlphaGo Zero保持了规范卷积构造,转而采用残差网络。这样就意味着在每一层,有一条中转途径可以直接从输出到输入,两头没有经过卷积操作。这样做的次要缘由是——残差衔接任务效果允许梯度信号 ,实践上这种衔接直接经过网络层。假如在晚期网络训练进程中卷积网络很难停止无效的任务,这时分依然停止无效的学习数据经过这些网络层,以便可以调理其他层。

因而,将棋盘表示作为输出,经过残差网络失掉特征向量并从这些向量中需求失掉两件事情: 第一件事是评价函数,评价函数很复杂,是一个0和1之间的整数。这个数字表示以后场面赢的概率,这个网络的第二局部是战略向量,这个向量实践上是一个概率散布,这个散布给出一切能够下子行为的概率。在现有的场面下显然人们需求的是训练零碎使得可以做出较好的下子行为,也就是整个棋盘表示需求选择更高概率去下出好棋,以及更低的概率下出坏棋。以上就是整个零碎的训练进程。

保持蒙特卡罗办法,转向复杂的两阶段搜索办法

训练分为两阶段停止:第一阶段应用职业选手的数据集停止监视学习,第二阶段训练好的网络开端停止自我学习。而新版本的AlphaGo Zero零碎不必数据集不应用任何职业选手的棋谱,完全经过自我对弈。

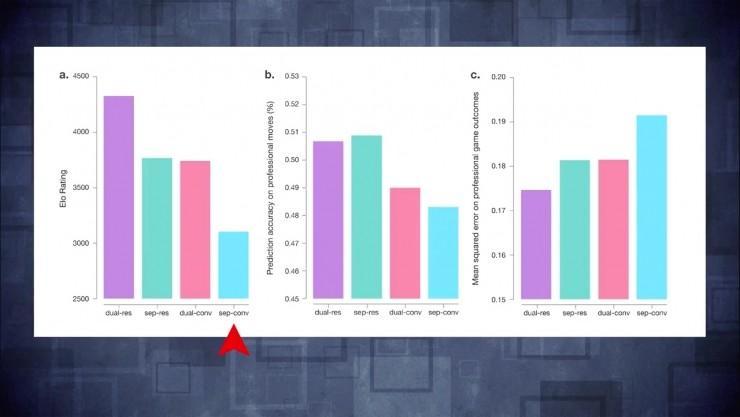

论文中给出了十分风趣的图,这个图展现了不同版本AlphaGo的功能。我们可以看到,亮蓝色是博得李世石的版本。最右边的柱状图最低,由于这张图表示了没有采用蒙特卡洛办法可以获得差的后果。

假如采用这个训练好的网络,假如只采用这个网络一次,将棋盘形态输出网络,从对策向量中,你失掉最好的下子方案,而不必做其他的事情。

从卷积网络切换到残差网络后,我们可以看到,左图柱状体是残差网络,左边是原始的网络,白色柱体是应用卷积神经网络组合评价函数和战略向量的后果。切换成残差网络后失掉了很大提升,把原始论文中的卷积神经网络切换成残差网络之后也会失掉异样的提升。同时组合评价函数和对策向量,我们可以看到紫色的柱状体,这也是最终零碎的功能后果。

关注雷锋网

(大众号:雷锋网)

,雷锋字幕组译制油管频道 Arxiv Insights 每周精选,从技术视角动身,带你轻松深度学习。

。