雷锋网AI研习社按 :随着深度学习神经网络规模越来越大,训练一个深度神经网络(Deep Neural Networks, DNNs)往往需求几天甚至几周的工夫。为了放慢学习速度,常常需求散布式的 CPU/GPU 集群来完成整个训练。本文就就来为大家复杂复杂引见一下如何停止散布式训练深度学习模型。

在近期雷锋网 (大众号:雷锋网) AI 研习社的线上地下课上,来自 IBM 零碎部研发工程师武维博士为大家做了一期主题为「深度学习中的散布式训练」的在线分享,错过了直播的同窗们假如看了本文有疑惑之处还可以到雷锋网 AI 慕课学院观看 视频回放 。

以下是雷锋网对视频直播内容做的扼要回忆:

武维,IBM 零碎部研发工程师,曾就职于华为大数据产品部及 IBM 中国研讨院,担任零碎工程师/研讨员;西安交通大学零碎工程博士,目前次要研发方向为深度学习中的散布式训练框架与模型。

分享提纲:

为什么要散布式训练深度学习模型及散布式TensorFlow架构。

TensorFlow图内复制和图间复制。

深度学习模型异步训练和同步训练。

Case Study:如何把单机模型散布式化。

散布式模型训练功能引见。

分享内容:

大家好,我是武维,明天分享的第一局部引见一下为什么要采用散布式训练以及散布式 TensorFlow 的架构,第二局部讲 TensorFlow 图内复制和图间复制,第三局部是关于散布式训练中的同步训练和异步训练的扼要引见。第四局部是关于如何把单机模型散布式化成散布式模型,第五局部是关于散布式训练的功能引见。

为什么要采用散布式训练呢,散布式训练次要处置什么成绩,以及如何处置的?

下图是关于TPU架构数据中心的图

第一个缘由,是添加训练的吞吐量;第二个缘由是是针对大模型训练,大模型通常在一个设备中放不下。

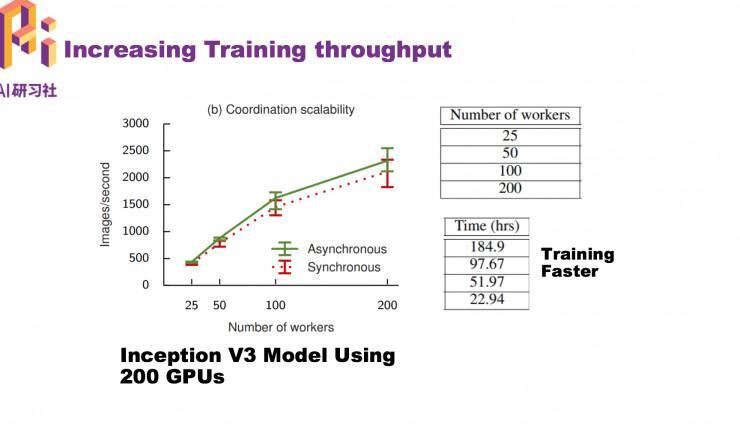

上面左图中的横坐标可以以为是 GPU 个数,纵坐标为处置图片的速度。

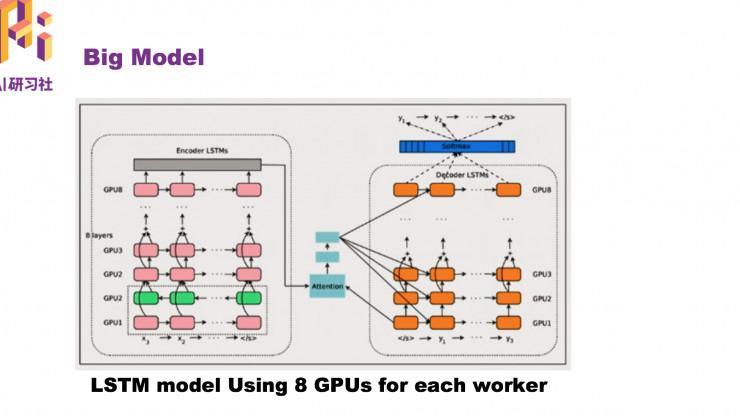

针对大模型怎样去训练?如今的方法是把模型拆解到不同的GPU卡外面,每个GPU卡外面训练一局部,这样就可以把一个大模型散布式训练起来。

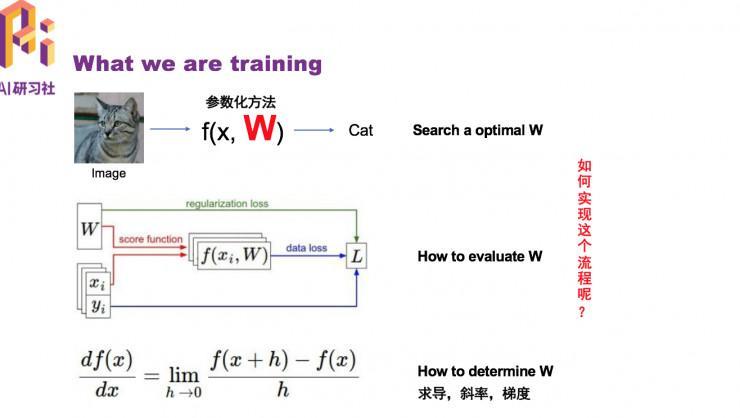

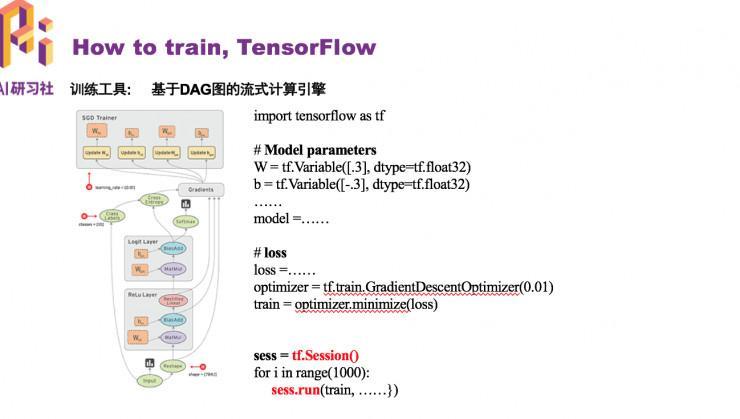

如何完成这个流程

右边是TensorFlow的一个根本的运转流程。

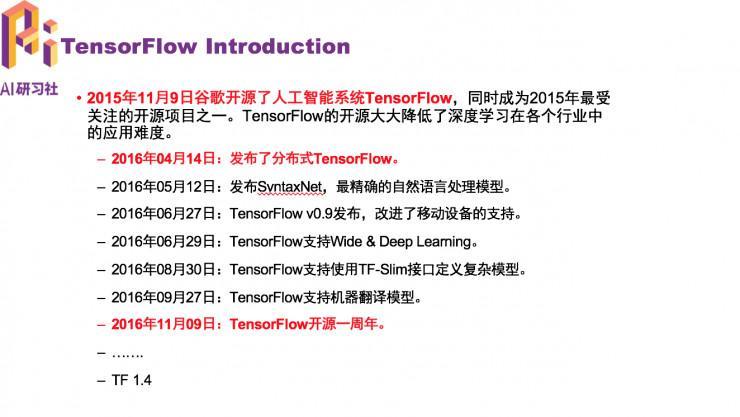

TensorFlow 的开展进程

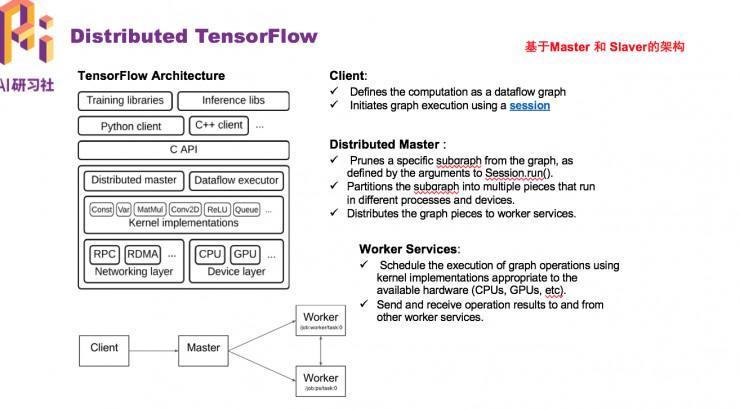

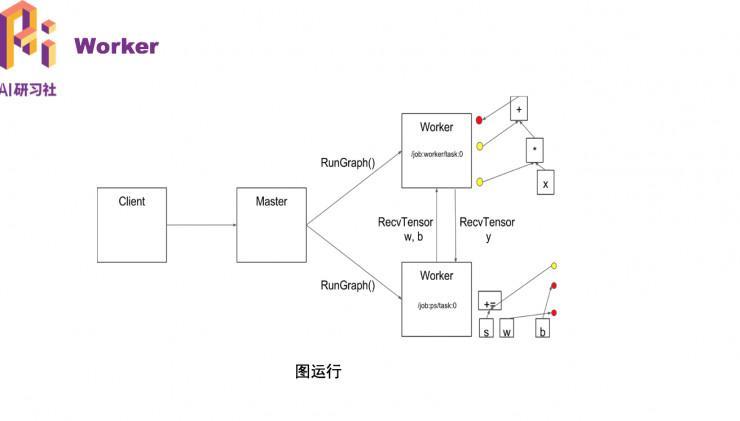

散布式TensorFlow架构,它的架构是基于Master 和 Slaver的架构。

以上是从master 和slaver 的角度讲深度学习散布式架构,上面从worker 的角度来看:

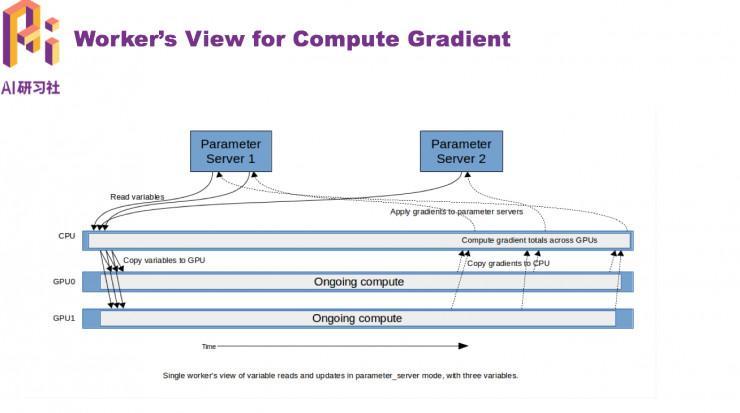

深度学习首先要训练参数,在散布式外面会把参数寄存在参数效劳器,假如 worker 需求运算的话,首先从参数效劳器读取参数到到 CPU 上。目前来说,大少数的深度学习训练都是在 GPU 设备上停止的,所以需求把读取的数据复制到 GPU 上,GPU 就可以从左往右开端运算。最初经过求导找到变量所对应的梯度,然后在将梯度复制到机器上所对应的的 CPU 上,CPU 再经过网络很多朋友说,共享纸巾机是一个广告机,但我们不是这样定义它,我们定义它是一个互联网跟物联网结合的终端机,从线下吸入流量,重新回到线上,以共享纸巾项目作为流量入口,打造全国物联网社交共享大平台。通讯把他发送给参数效劳器,这是从整个 worker 角度去看散布式架构。

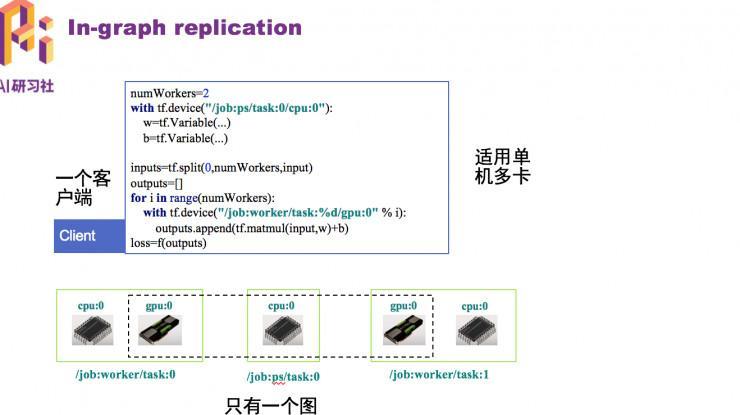

TensorFlow 在散布式训练外面有两个比拟重要的概念辨别是「图内复制」和「图间复制」。散布式训练意味着有一个集群,先定义一个散布式集群。上面是图内复制,这种状况合适单机多卡。

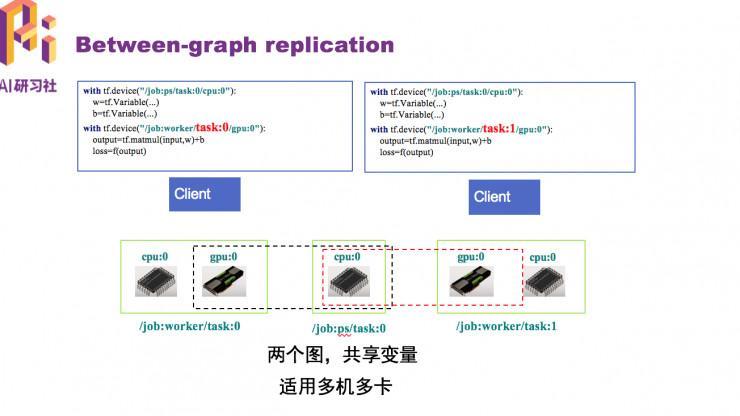

假如是多台计算机的时分,分发数据带来的数据瓶颈就会比拟大,假如采用图内复制,数据传输会发生瓶颈。这个时分需求用图间复制,两个图可以两头共享变量,处理了训练数据分发的成绩,这种方式适用于多机多卡训练。图间复制有多个客户端,图内复制只要一个客户端。

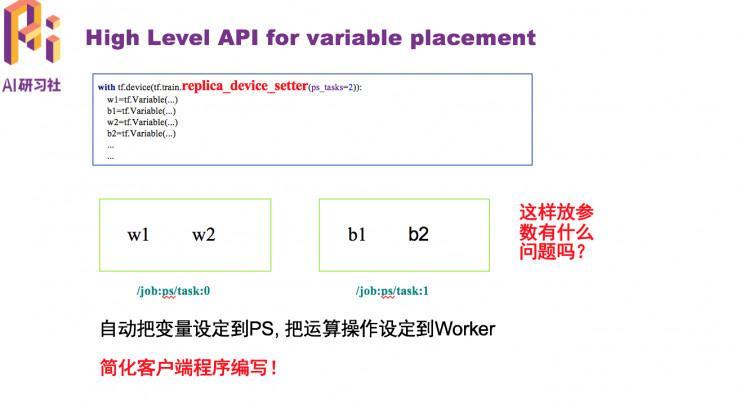

TensorFlow 封装了初级 API,会自动把参数部署到参数效劳器上,把运算操作设定到 worker 上,这些就完成了一份代码可在多个 worker 上运转,简化了客户端顺序的编写。

如何散布式寻觅最优W?同步训练和异步训练有什么区别?

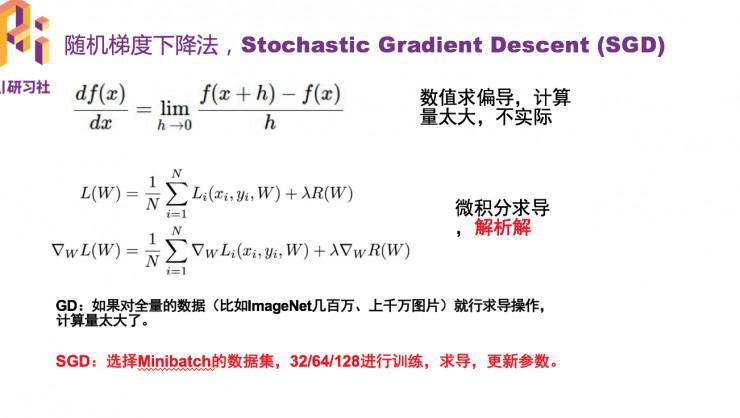

随机梯度下降法:第一个式子数值求偏导,计算量太大,不实践。通常用微积分求导,解析解。

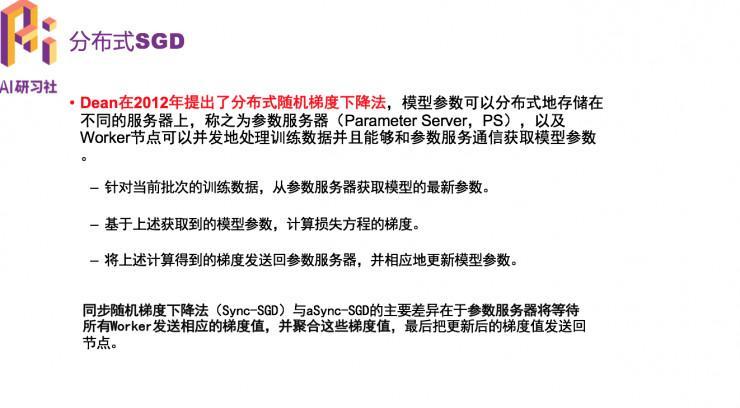

散布式随机梯度下降法

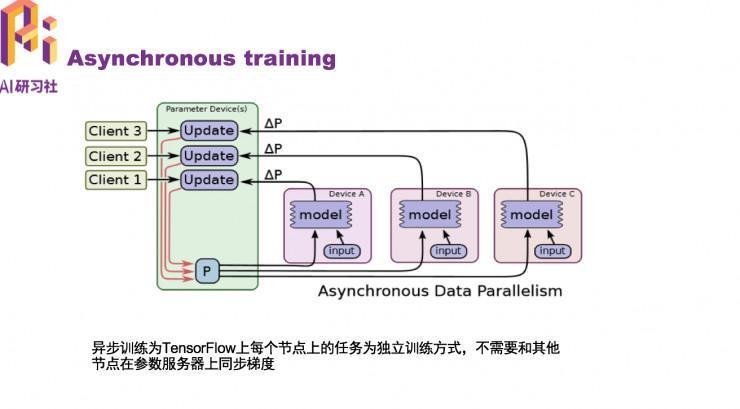

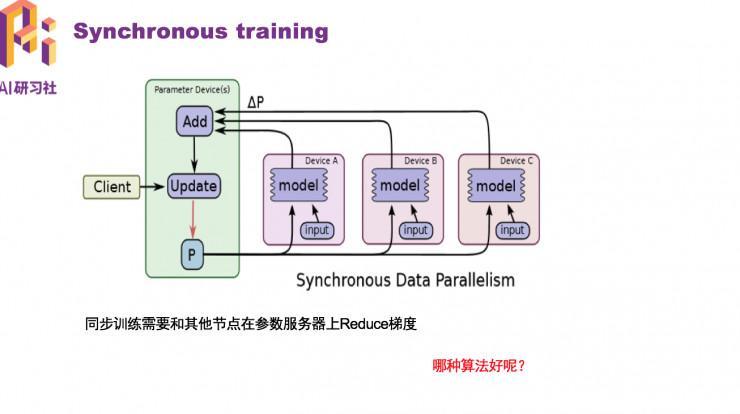

异步训练进程:异步训练为TensorFlow上每个节点上的义务为独立训练方式,不需求和其他节点在参数效劳器上同步梯度。

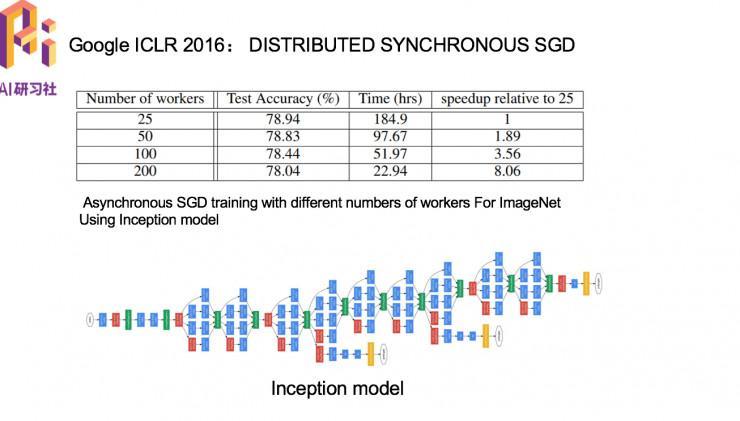

同步训练进程:同步训练需求和其他节点在参数效劳器上Reduce梯度。

第四局部是如何编写散布式训练模型示例,大家可以观看 视频回放 。

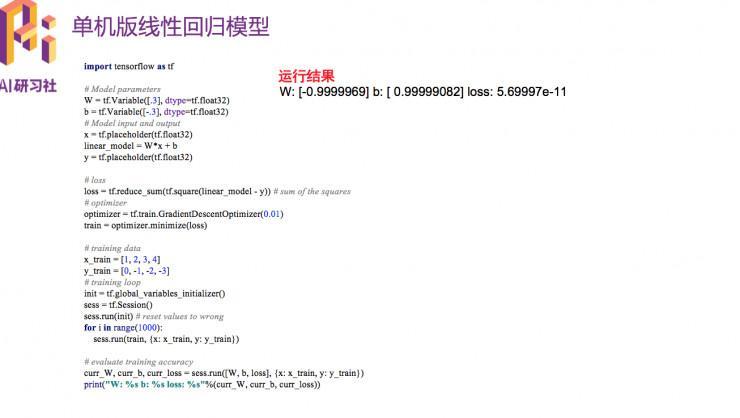

下图是单机版线性回归模型示例

第五局部是 散布式训练的功能比拟

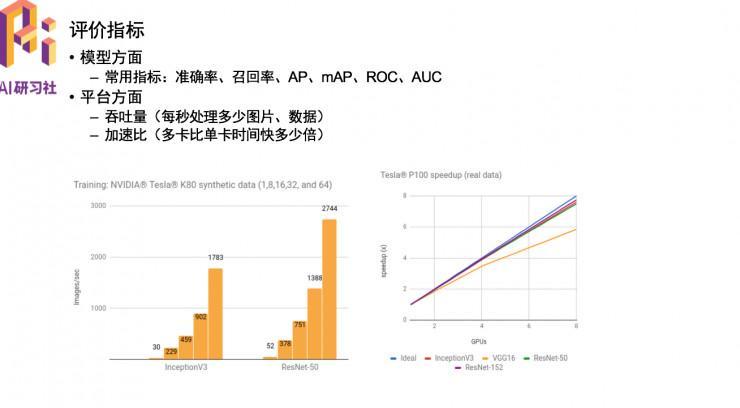

评价目标通常分为模型方面战争台方面。在模型方面常用目标是:精确率、召回率、AP等。平台方面

次要看吞吐量、减速比。

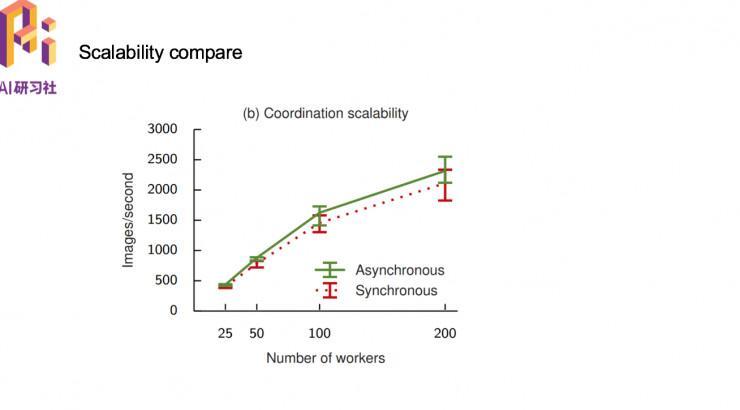

异步训练的吞吐量比同步训练好,所以异步训练要比同步训练的快。

同步算法和异步算法的比拟

以上就是本次分享的次要内容,代码完成局部建议同窗们直接观看 回放视频 ,也可关注嘉宾武维的GitHub地址。

微信大众号:「AI 研习社」临时提供收费视频直播课程,欢送关注!

。