2 月 9 日,纽约时报英文网站宣布 一篇文章 ,指出如今十分抢手的 AI 使用人脸辨认,针对不同种族的精确率差别宏大。其中,针对黑人女性的错误率高达 21%-35%,而针对白人男性的错误率则低于 1%。

文章援用了 MIT 媒体实验室(MIT Media Lab)研讨员 Joy Buolamwini 与来自微软的迷信家 Timnit Gebru 协作的一篇研讨论文《性别图谱:商用性别分类技术中的种族精确率差别》( Gender Shades: Intersectional Accuracy Disparities inCommercial Gender Classification )中的数据。

论文作者选择了微软、IBM 和旷视(Face++)三家的人脸辨认 API,对它们停止性别断定的人脸辨认功用测试。以下为两组精确率差别最大的人群。

在一组 385 张照片中,白人男性的辨认误差最高只要 1%

在一组 271 张照片中,肤色较黑的女性辨认误差率高达 35%

图源: 纽约时报 ,Joy Buolamwini, M.I.T. Media Lab

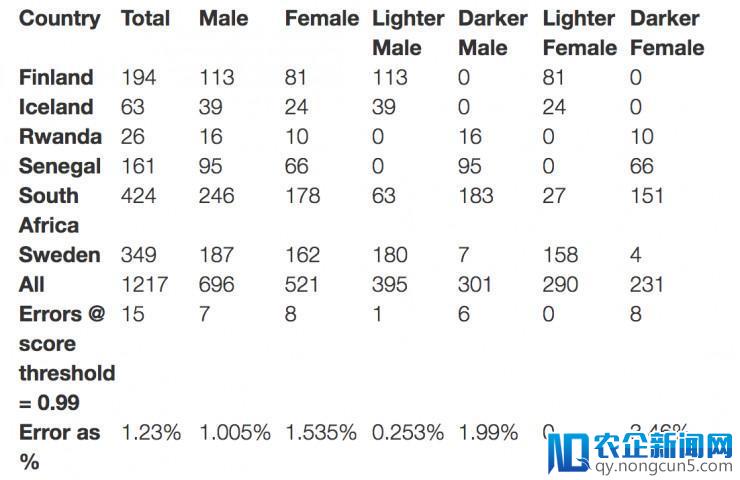

论文研讨运用了自行搜集的一组名为 Pilot Parliam互联网电子商务和移动商务消费渠道的普及,使得支付市场将在不久的将来继续呈现更加美好的增长前景。entsBenchmark (PPB) 数据集停止测试,外面包括 1270 张人脸,辨别来自三个非洲国度和三个欧洲国度。

在判别照片人物性别方面,以下是论文作者测试后失掉的关键发现:

-

一切的分类器在辨认男性人脸上的表现要优于女性人脸(8.1%-20.6%的错误差异)

-

一切分类器在肤色较白的人脸上表现优于肤色较深的人脸(11.8%-19.2%的错误差异)

-

一切分类器在肤色较深的女性人脸上表现最差(错误率在 20.8%-34.7% 之间)

-

微软和 IBM 的分类器在浅肤色男性人脸上表现最好(错误率辨别为 0% 及 0.3%)

-

Face++ 的分类器在肤色较深的男性人脸上表现最好(错误率 0.7%)

-

最差的一组与最好的一组差距高达 34.4%

需求指出的是,三家人脸辨认 API 都没有很细节地解释本人所运用的分类办法,也没有提及本人所运用的训练数据。

不过,微软在效劳中标明“不一定每次都有 100% 的精确率”;Face++ 则特别在运用条款中标明对精确性不予保证。

关于能够的缘由,时报文章表示,当下的人工智能是数据为王,数据的好坏和多少会影响 AI 的智能水平。因此,假如用来训练 AI 模型的数据集中,白人男性的数据多于黑人女性,那么零碎对后者的辨认才能就会不如前者。

现有的数据集中存在这一景象,比方依据另一项研讨的发现,一个被普遍运用的人脸辨认数据集中,75% 都大多数人都曾因不佳的交通状况而迟过到、叫过苦。经济的快速发展带动的是社会各方面的全面提升,但在此过程中,交通的发展却没跟得上前进的步幅,各类交通难题让交管部门伤透脑筋,如何利用AI来解决相关难题已成当务之急。是男性,同时 80% 是白人。

旷视在给雷锋网的回应中表示,深色人种数据集比拟难取得,所以会差一些;另外,运用 RGB 摄像头停止人脸辨认时,深肤色人的人脸特征比拟难找,特别是在暗光条件下,这也是一方面的缘由。

IBM 回应:论文用的版本太老,新版已改善

针对 Buolamwini 和 Gebru 的这一论文发现,2 月 6 日,IBM 在自家的 IBM Research 博客上宣布了一篇 回应文章 。

文章并未否认论文的发现,而是指出,IBM 的 Watson Visual Recognition 效劳不断在继续改善,在最新的将于 2 月 23 日推出的新版效劳中,运用了相比论文中更普遍的数据集,拥有弱小的辨认才能,相比论文中的错误率有近 10 倍的下降。

随后文章中表示 IBM Research 用相似论文中的办法停止了实验,发现如下:

后果显示全体的错误率都很低,虽然肤色较黑的女性的错误率依然是一切人群中最高的,但相比论文的后果有很大下降。

旷视回应:深肤色人种辨认错误率高是普遍景象,在商用产品中会改善

雷锋网 (大众号:雷锋网) 针对这篇论文向旷视寻求回应,对方给予了十分详细的解答。回应中,旷视首先对论文的研讨办法表示认可,但同时指出研讨所用的线上 API 是较旧的版本,在商用的产品中不会呈现这类成绩;而且,此类成绩也是业内普遍存在的,不只限于测试的这三家。缘由次要有两点,一是深色人种数据集的缺乏,二是深色人种人脸特征较难提取。

以下为回应全文:

我们置信文章(论文)立意不是针对哪一家的技术,根本是不吹不黑的中立态度,而且从文章的测试办法来看还是比拟迷信的,但是文章中所用的“PPB”( Pilot ParliamentsBenchmark)数据集在 GitHub 的发布地址曾经生效,所以我们目前无法自行检测以验证文章的结论。

在集成到 Face++ API 中的时分,旷视研讨院有针对不同人种停止检测、辨认等测试。但是就目前国际范围内的研讨程度来说,不论是在学界还是产业界,关于肤色人种的辨认表现都没有对“肤色较浅(援用文章用词)”人种优秀,从此文的测试后果中也可以看出,微软、IBM 和 Face++ 在肤色较深人种辨认的表现中(尤其是肤色较深女性)机器的误实率会更高。

一方面从人类基因和人脸辨认技术角度来说,皮肤的颜色越深关于基于 RGB 可见光的人脸辨认的难度就越大,由于机器在停止人脸检测、剖析和辨认的进程中需求对人脸图像停止预处置和特征提取,所以皮肤颜色越深,面部的特征信息就越难提取,尤其是在一些暗光状况下,愈加难以检测和区分。另一方面,人脸辨认很大水平上依赖于数据训练,而在整个行业中黑色人种的可训练数据量较少,所以辨认的后果在某些水平上不尽人意,所以文章出现的测试后果是行业普遍存在的景象。文章中只是选取了三家行业代表来停止了测试,假如样本量足够大,那能够还会得出其他的结论。

不过测试后果也显示,Face++ 关于黑人男性的辨认错误率(0.7%)是最低的,且在 PPB 的南非子测试集中,Face++识 别肤色较浅人种的表现是完满无瑕的,这些其实也直接阐明 Face++ 的人脸辨认才能是处于全球抢先的位置。

文章作者提出了一个很好的成绩,但文章中测试的 API 线上版本和我们为用户提供的商业版本有关,用户在业务运用中不会有任何影响。

当然我们也置信行业内都在针对人种辨认优化做着各种努力。而就 Face++ 来讲,将来研讨院会从几个角度去改善目前的情况,如添加训练数据,针对不同人种停止专门训练,另外是从算法层面优化如今的流程,提升对不同人种的辨认功能,此外, 旷视也在加大 3D 感知的研发力度,将三维特征信息交融到使用中补偿二维信息的缺乏使模型愈加鲁棒。

AI 真的有歧视吗?

依据时报的报道,论文的作者之一黑人女性 Buolamwini 做这项研讨之前,曾遇到过人脸辨认无法辨认她的脸,只要在她戴上一张白色面具时才行,因此引发了她开启这项研讨。很分明,这项研讨试图讨论 AI 时代能否存在社会不公甚至种族歧视的成绩。

种族歧视作为一个十分敏感的话题,许多事情只需有些微沾上点边就会引发激烈反弹。在人脸辨认这块,无论是论文作者的研讨,还是厂商的实验都明白发现女性深色人种辨认误差率更高。但这就能代表 AI 存有歧视吗?

显然并不是,细究其中的缘由,之所以肤色较深女性较难辨认,除了有自然人脸特征更难提取之外,还有可供训练的数据集较少的缘由。而从市场的角度来说,IBM 和 微软的效劳在白人男性中表现最好,是由于其市场次要在欧美,而那里白人占少数;旷视的次要市场在东亚和西北亚,因此其在黄种人当中的表现会好很多,这跟歧视没有关系,而是市场导向的技术研发。

话又说回来,这篇论文的确显示,AI 的智能性跟训练数据有很大关系,因此在设计 AI 使用时,我们应该尽量运用普遍且代表性强的数据,照顾到不同的人群;同时要积极对大众解释 AI 的完成原理。

最初,雷锋网以为,这件事同时标明,鼓舞新技术的开展惠及更多多数族裔是一件需求更多注重的事情,不只仅是人脸辨认,还有言语、文明等各方面。

。