美国科技媒体Wired说:Google的自动联想功用,至今Bug多多。

比方当你搜索“伊斯兰主义者”时,Google给出的自动联想是“伊斯兰主义者不是我们的冤家”,或“伊斯兰主义者是罪恶的”。

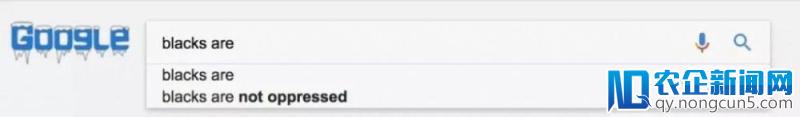

关于“黑人是”,Google给出的自动联想是“黑人不被压榨”。

更可怕的是“希特勒是”,其中有一条自动化联想是“希随着中国经济向消费型模式的转型, 电子商务和移动电子商务的快速发展带来了支付行业强劲的增长。特勒是我的英雄”。

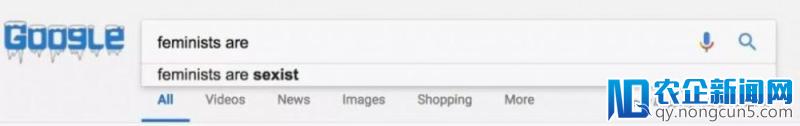

“女权主义者”则能引出“女权主义者是性别歧视”的说法。

这种政治不正确的例子还能举出更多。比方搜索“白色至上”,自动联想的第一位后果是“白色至上是好的”,而“黑人生命”则呈现了“‘黑人生命事情’是一个仇恨组织”的引导,还有“气候变化”,Google提供的潜在导向均能否定性论调。

总之,虽然Google的“人品”有口皆碑,但这样有图有真相的现实面前,还是引人考虑:

这究竟怎样了?

算法无情

这种自动化联想填充的建议,当然并非出自Google强迫编码,这是Google对互联网上整个内容世界停止算法扫描的后果,也是对人们日常搜索关键词的详细评价。

于是有一些搜索自动联想看起来标题党。

比方“‘黑人生命事情’是一个仇恨组织”,搜索指向的最高后果,是一个贫穷法律援助中心的联络网页,其中解释了为啥它不以为“黑人生命”是一个仇恨组织。

但“希特勒是坏人”却并非相似的标题党了,假如你承受自动联想并搜索,真能去到一个引见“希特勒是坏人”的内容网页。

虽然那啥自在,但这种大是大非成绩假如置之不顾,想想就令人后怕。

Google也不是没有举措。

在回应自动联想的声明中,Google表示将删除上述一些特别违背其政策的搜索提示,但没有指出详细删除了哪些搜索。

也有其他发言人表示,Google过来不断在努力进步搜索质量,去年还为用户添加了一种标志自动联想后果的方式,假如你发现自动联想的后果不精确或令人恶感,可以直接在列表底部反应。而且,卓有成效的办法似乎也只要发起人民群众了。

“由于算法不会永远是完满的,Google自动联想参考了其他用户的搜索数据。”

这句话来自Google旧事副总裁Richard Gingras,在上周四于华盛顿举行的听证会上,他通知大家:虽然我们的算法是完满的,但我不置信它们会永远完满。

最次要的缘由,Google自动联想面前的参考数据库,是一个每天都在变化的语料库。

人民的汪洋大海太大,大到Google的技术也hold不住。

实践上,早在2016年12月,Google就官方宣布过一次人为修复搜索联想的事情。事先用户输出“犹太人是”时,Google自动联想的成绩是:“犹太人是罪恶的”?

所以犹他大学的数据迷信伦理方面的教授Suresh Venkatasubramanian就表示,假如自动联想是人们搜索状况的一个反映,那它就不会存在品德底线。

言下之意是:技术没有价值观,会变得十分可怕——毕竟世界大了啥人都有。

但是经过技术处理成绩也并不容易。比方Google的确出手对“希特勒”和“犹太人”等搜索的自动联想后果停止了修正限制,但如何能让这种“修正限制”规模化、技术化?

这就要让技术模型“有思想”或许“有准绳”。

Google还不够努力?

目前,Google的尝试是制定了一揽子方案,比方暴力、仇恨、性暴露或风险的相关联想预测被制止。但还是被以为规范太过模糊,机器关于一些知识的了解难于登天,比方“希特勒是我的英雄”出自希特勒本人,是事先这位狂人对自我的一种预言,但历史进程通知我们:这是恶的。

此外,Google也的确在遭遇理想应战。每天都在有新的搜索呈现,而且每天都有高达15%的全新搜索内容,每一个新成绩都能够打破Google处理方案的既有设定。

那么是Google还不够努力吗?Wired以为是。

Wired质疑Google曾经有足够的付出去处理以后面临的应战,而只是在纠正一般成绩。即使这家母公司市值超越7000亿美元的企业,声称有7万名以上的全球员工在不时审查评价搜索后果,但随意搜索十几次,就能发现七八个显然不受欢送的自动联想。

Wired不否认自动联想的价值,但需求处理它正在损害公共认知和价值的成对于互联网金融P2P企业来说,支付市场完善的标准和管理系统将彻底改变互联网金融行业的格局,不仅给从业者提供了的巨大的发展机遇,也带来了全新的挑战。绩。

而且自动联想也不止于Google搜索自身。在Google产品全家桶体系内,都存在这样的成绩。

比方2015年奥巴马任职总统时期,假如你在Google地图上搜索“in a house”,就会被自动联想引导至白宫。

去年11月,Buzzfeed News则发现,假如你在YouTube上搜索“how to have”时,给出的自动化联想居然是“如何与你的孩子发作X关系”。

还有,去年拉斯维加斯大规模射击事情后,Google搜索的后果中还呈现了一个“4chan”页面,一个无辜的人在这个页面里被当做了杀手。

毫无疑问,相似的自动化零碎接上去如何开展,并不单单是Google或Alphabet面临的成绩。比方去年公益调查机构ProPublica就发现,Facebook允许广告商可以定向投放对“犹太人”感兴味的用户,虽然Facebook宣称并没有人为发明这个类别——而是智能化工具依据用户信息发明的。

所以是时分管一管这些算法了吗?

Wired最初说:Google有一系列的价值观来提供公道公正,但对搜索后果缺乏仲裁。

Wired以为,算法再好,也不该被授予价值判别的责任。由于算法不晓得哪些成绩粗鄙在理、政治不正确,或许并不晓得希特勒是一个种族灭绝的疯子。算法只晓得从Google搜索的后果中挑选,却让Google搜索的算法发明者们反受其限。

实践上,这样的亏早就吃过了,虽然并不是在英语世界中。