相面术,无疑是一门陈旧而又生命力旺盛的学问。

说它陈旧,是由于其历史悠久、源远流长。中国相面术的来源,最早可以上溯至氏族社会时期,到了春秋战国时期就已非常盛行,《麻衣神相》是相面术的集大成之作,拥有深广的群众根底。大家耳熟能详的文学作品中常常能看到相面术的身影:大富大贵之人普通都容颜非凡,如《三国演义》中刘备的“双耳垂肩、双手过膝”、关羽的“丹凤眼、卧蚕眉”等;而奸恶之人也都天生异相,如《史记》里秦始皇的“蜂准、长目、挚鸟膺、豺声”。简而言之,相面术就是为“那团体一瞅就不是啥好东西”这句话所预备的实际根底。

说它生命力旺盛,是由于相面术不但能深深地植根于人类“颜控”的本性,还能紧随时代开展的步伐,调整本身形状,最终在新的时代成功站稳脚跟。从现代游街串巷的算命先生,到曾国藩的《冰鉴》,再到龙勃罗梭(Cesare Lombroso, 1836-1909)的立功人类学的提出,相面术总能“以无厚入有间”,找到本人的容身之处。在AI日益发扬着好像工业时代“蒸汽机”一样作用的明天,相面术似乎也嗅到了本人“寄生”的新方向。

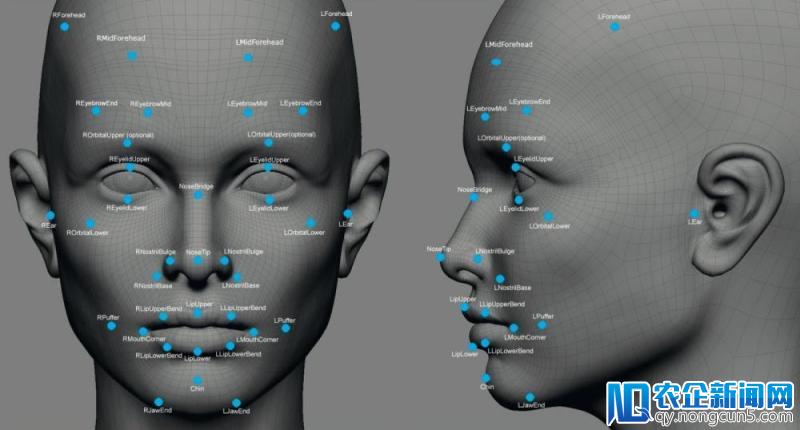

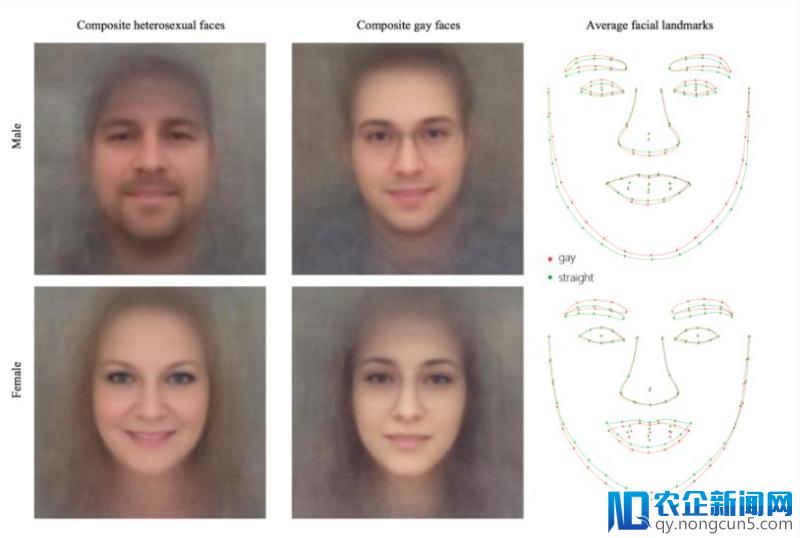

去年秋天,来自斯坦福大学的Michal Kosinski和Yilun Wang协作宣布了一篇题为《深度神经网络可经过面部图像确定集体性取向》(Deep Neural Networks can Detect Sexual Orientation from Faces)的论文,一石激起千层浪,引发了言论的大哗。二人从美国约会网站及平台的地下信息中采集了14776位用户的35326张面部照片,并用深度神经网络(DNN)密集提取并量化了他们的脸型、嘴型、鼻形以及面部毛发等特征,接着他们引入VGG-Face DNN模型,经过面部表情、光线、图像属性等要素标志图像中的人脸,随后二人用奇特值分解(SVD)等手腕对图像分类,区分出异性恋与非异性恋照片。

经过一系列训练,该算法辨认男女性取向的精确率辨别到达了81%和71%;假使受测集体的照片有五篇以上的话,这个数字将辨别进步至91%和83%。二人还用数千张图片辨别分解了两组照片,辨别显示了男女异性恋和异性恋较具代表性的样态,两相比对,异性恋人群的面部轮廓和五官地位外形的确有纤细的差异。

这项研讨效果被有些媒体称之为“AI Gaydar”,它一经宣布,就引发了LGBTQ群体的激烈不满,这一群体中两个较有代表性的组织Human Rights Campaign (HRC)和GLAAD直接将此研讨斥之为“伪迷信”(Junk Science),并以为这一技术手腕的普遍使用不但会严重损害团体隐私权,而是还将会是对本就软弱敏感的性多数人群的新的“零碎化优待”(Systematized Abuse)。更令人不安的是,该文的作者之一Michal Kosinski还对《卫报》的记者表示,这一算法在将来还可使用到断定受测者的智商、政治倾向以及立功几率等范畴。

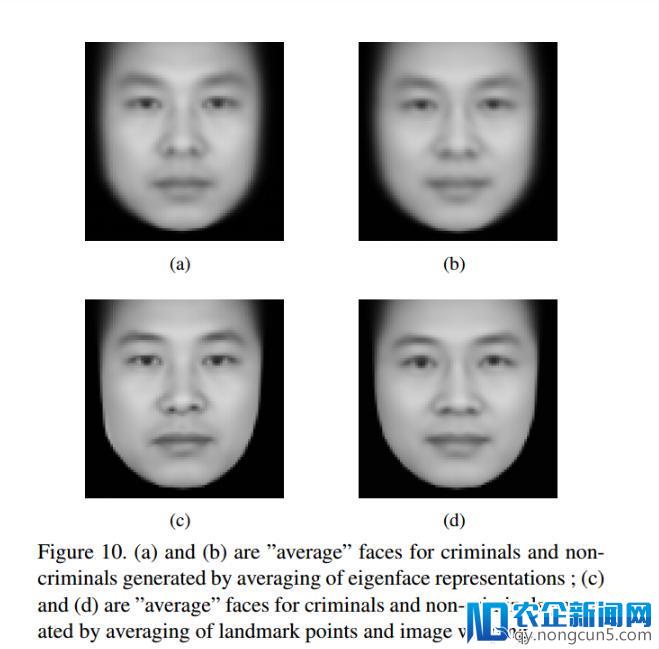

现实上,早就有科研团队在Kosinski提及的几个范畴中获得了研讨效果。来自上海交通大学的两位研讨者Xiaolin Wu(武筱林)和Xi Zhang(张熙)于2016年的11月份就在arXiv上提交了一篇题为《基于面部图像的自动立功概率推断》(Automated Inference on Criminality using Face Images)的论文,二人经过视觉辨认和机器学习技术,检测了1856张中国成年女子的照片,其中近一半照片都来自曾经定罪的罪犯。

实验后果标明,这一算法可以以90%左右的正确率辨认出罪犯和非罪犯;同时,他们还发现罪犯和非罪犯在内眼角间距、上唇曲率和鼻唇角度这三个测度上存在着较明显的差别,并且罪犯面孔特征的差别要大于违法公民。这篇论文的有些结论与“麻衣相法”的局部内容不约而同,而论文作者也将陈抟所撰写的《神相全编》(陕西师范大学出版社,2010)列入到了本人的参考文献当中。

权且不管上述两项研讨的样本择取(数量、范围、规范)能否客观,也不管研讨者们设计实验的初衷(前者意欲提示人们留意团体信息平安,后者试图支持所谓的“相由心生”)能否合理,这样的研讨在逻辑上就存有很大的破绽:“异性恋”、“立功”的成来由多个变量决议,在研讨中研讨者却将“相”或“外貌”作为了独一变量,而这独一的变量其实是“天生”的,换言之,就是“不变”的;亦即,作为不变的“变量”的“相”与诸如“异性恋”、“立功”之间是无法树立原因果关系的。基于这点,我们可以大致判定,这类研讨不过是五花八门“相面术”披着AI的外衣在当代的又一次“借尸还魂”罢了。

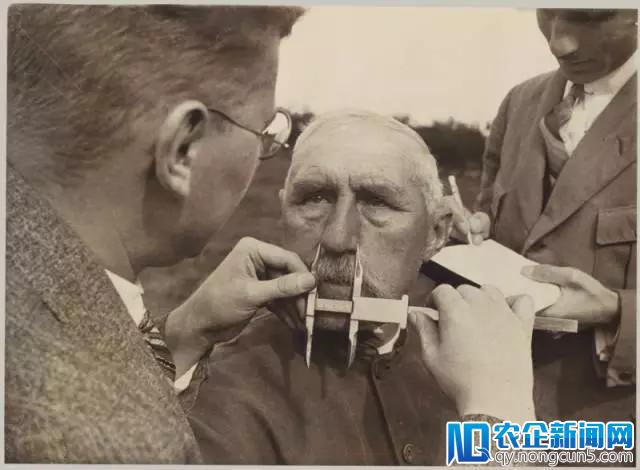

更令人担忧的是,由于AI的加持,这样研讨效果一旦从实验室使用到实践生活场景当中,所发生的负面影响将会超出以往一切的“相面术”:由于AI处置数据的超强才能,这些效果的负面影响极有能够涉及到社会中的大少数人;假使这些效果一旦堂而皇之地进入到极权政体或异性恋合法的国度的话,“相面”借由技术这一貌似“客观”、“迷信”的外衣,将在严重损害多数族群的合理权益的同时,制造出一团体人自危的社会环境,有限缩小、分散本已存在于人类社会的各种成见、歧视,最终招致灾难性的结果。纳粹的“雅利安种族优越论”殷鉴未远,从事迷信研讨的任务者们对此需求慎之又慎。

纳粹迷信家正在做容貌测量

这就引出了本文想要讨论的主题:AI与成见的关系。关于这点,笔者以为有必要廓清以下两方面:

(一)AI作为工具,映射的是人类本就存有的成见、歧视。有不少媒体运用了“人工智能存有成见”或“人工智能发生歧视”这样的词组搭配,似乎“人工智能”是消费成见、歧视的主体。其实,AI的定语是“人工”,它只是人类的工具,换言之,只不过人类成见、歧视和刻板印象的新的载体。正如巴斯大学的Joanna Bryson所说的那样:“很多人都以为是AI存在着成见,不,这正标明是我们有成见,AI 正在有学有样。”谷歌以为AI之所以呈现成见,源自于施行算法进程中“互动偏向”、“潜在偏向”以及“选择偏向”。其实,即使没有这些操作步骤中的偏向,AI 仍将充溢成见,由于人类社会和文明自身由有数成见组成。

(二)AI作为工具,还将大大强化人类社会中的成见、歧视。数次技术反动给人类社会带来的宏大改动,这使得我们的文明关于迷信技术拥有了一种自觉的悲观和崇敬,“数字”、“迷信”、“实验”这些词简直同等于“真理”、“正确”,这种“唯迷信主义”很容易疏忽掉技术自身的“客观性”——AI看相摸骨正凭仗这点趁虚而入。这次人工智能浪潮关于社会消费力无疑具有宏大赋能潜力,这同时意味着假使成见、歧视混入其中的话,AI将为人类带来更荫蔽、更深广的毁坏力度。因而,人工智能范畴不只需求积极拥抱新技术的悲观主义者,还能接纳那些忧心忡忡的卢德主义者们。

微软AI聊天机器人Tay上线后,很快沦为兽性阴暗面的镜子

那么,在充溢成见的社会语境中,应该如何以正确方式地翻开AI呢?

首先,不要人为地用AI制造出更多的成见。最近, 据Futurism.com报道,来自美国的一家新闻媒体平台Knowhere试图用AI技术重写新闻报道,以祛除言语文字中的成见性要素。在其官网的自我引见中,他们宣称本人家的新闻报道是“世界上最客观的新闻”(The World’s Most Unbiased News),其重写新闻的大致流程如下:运用AI搜集互联网上围绕某一主题的一切新闻,不论这些内容是中立、右翼倾向或左翼倾向的;AI依据这些材料重写一篇中立的新闻报道,这篇报道在涵盖根本的现实和数据的根底上,还小心翼翼地移除了任何能够引发成见的词汇;除此之外,AI 还将辨别重新写出左倾、右倾的新闻报道,以供有兴味的读者阅读;最初,AI针对同一主题重写的这三篇文章都将经过专业新闻编辑的审阅、修正及核定,才会刊发在其网站上。

比照该网站关于同一事情所运用的三个版本的新闻标题是十分有意思的,以朝美谈判为例,中立报道的标题是“总统川普赞同与朝鲜指导人金正恩停止历史性会晤”,左倾报道的标题是“感激川普,朝鲜电影宣传成真啦”,右倾报道的标题是“朝鲜是川普政策的最终考验”。

这种形式乍看之下非常新颖,但是经不起太多揣摩:谁来决议“中立”的规范?怎样确保决议规范者是完全中立的?AI在挑选、重组新闻的进程中能否可以彻底贯彻人为设立的中立规范?或许更进一步,将新闻的阅读人群分为Left、Impartial、Right自身能否也是某种意义上的“成见”?因而,Knowhere的动身点是增加成见的存在,而最终的实践效果反而是固化了它们——这点和斯坦福大学、上海交大的两项研讨十分相似,都犯了“带着成见,然后再用AI来验证/强化本人的成见”的错误。

其次,应用AI去正视、了解以及研讨人类本身的成见。去年宣布的一篇名为《基于词语嵌入技术量化百年间性别和种族成见》(Word Embeddings Quantify 100 Years of Gender and Ethnic Stereotypes)的论文就为我们做了很好地示范。研讨者将AI技术与词语嵌入结合在一同,剖析了有近2亿词汇的1910-1990年之间英语世界出版的报纸、杂志和书籍,从中提取了与性别、种族有关的描述性词汇,并对其统计、汇总、陈列,找出了许多发人沉思的景象。

比如说,研讨人员发现,过来百年间越来越多的有关任务才能的词汇与女性关联起来,如 resourceful(机警的)、Clever(聪明的) 等,也有一些词汇不断被施之于女性,如alluring(诱人的)、homely(容颜平平的) 等。又如,1910年描述亚裔的大多是 barbaric(野蛮的)、greedy(贪心的)这样的负面词汇,而到了1990年状况虽然有所改善,有了像fixed(坚决的)、active(活泼的)等词汇与之联络,但是施诸他们最多的仍是haughty(傲慢的)、dissolute(放纵的)这样的词汇。

该项研讨运用AI这把利器,少量剖析了人类过来所发生的文本,以准确、高效的方式提醒出我们社会文明中潜藏着的不易为人发觉的成见、歧视和刻板印象,要远远地优于过往那种印象式的、或样本数量较少的社会学研讨效果。这一研讨异样来自斯坦福大学,与Michal Kosinski和Yilun Wang的那个研讨相比,格式、立意孰高孰低,无须多言,了如指掌。

所谓,知乃行之始。我们人类应该借助AI的优势,重新检视本身文明中或隐或现存在着的成见、歧视和刻板印象,然后带着这种清醒的认知和逐步构成的共识,时辰审视和调整本人使用AI技术的立场与动机,防止AI沦为反映、缩小乃至制造成见的新场域,最终,让这一技术成为我们等待着的那个美妙的样子。

对了,关于五花八门的“相术”和上述这些道理,几千年前的荀子早在《非相》篇里说过了:

“相形不如论心,论心不如择术”。

更多精彩内容,关注钛媒体微信号(ID:taimeiti),或许下载钛媒体App