作者: Emanuel TIMOR 、夏志进、Brian TOH、Tracy JIN

在人工智能芯片研讨报告的第一局部中,我们剖析了人工智能的驱动要素。第二局部,我们将讨论由人工智能主导的对算力的需求将如何推进这些趋向:

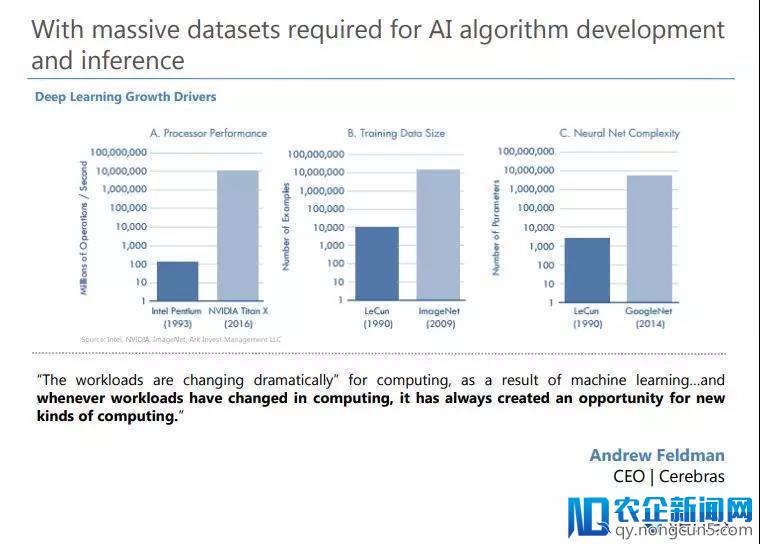

1)将来基于深度学习的神经网络算法的训练将会依赖更少量的数据集

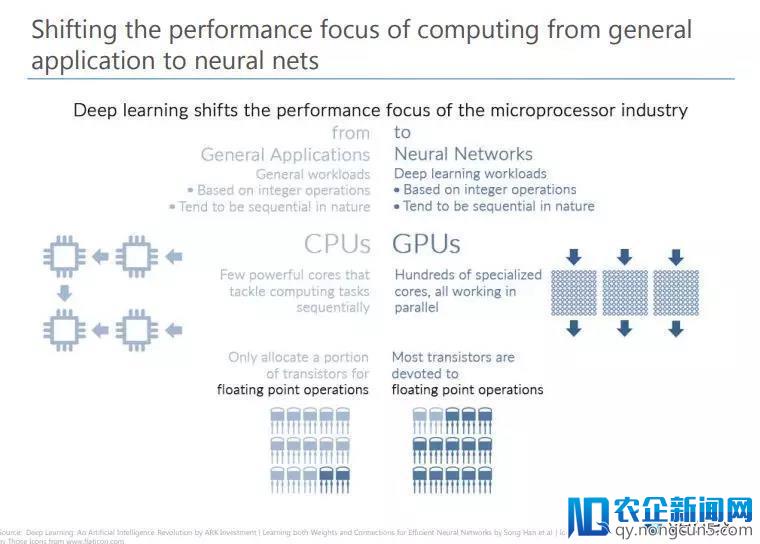

2)这将会招致对计算功能的要求从普通使用转向基于神经网络的使用,即添加对高功能计算的需求

3)深度学习算法既是计算密集型的,又是内存密集型的,对处置器的功能要求极高

4)因而,一些 创业 公司研发新的人工智能优化芯片将会减速人工智能在各个范畴的使用

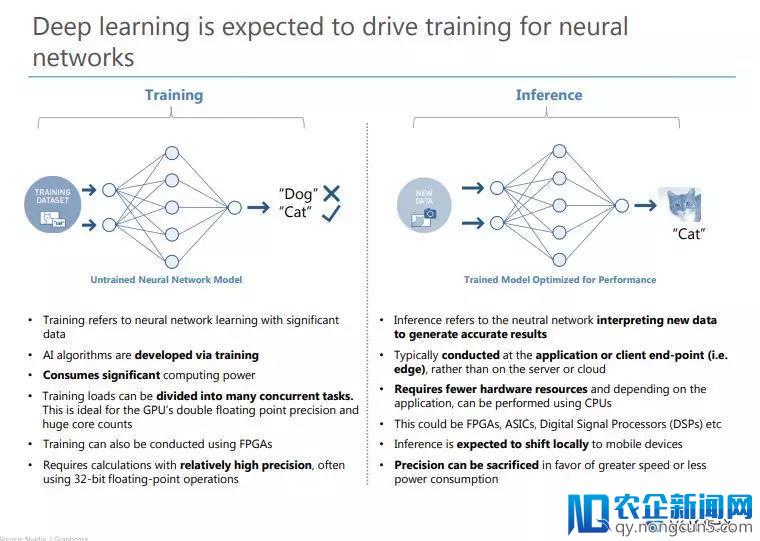

深度学习将继续推进神经网络算法训练

人工智能算法的优化需求越来越多的数据集

对计算功能的要求将会从普通使用转向基于神经网络的使用

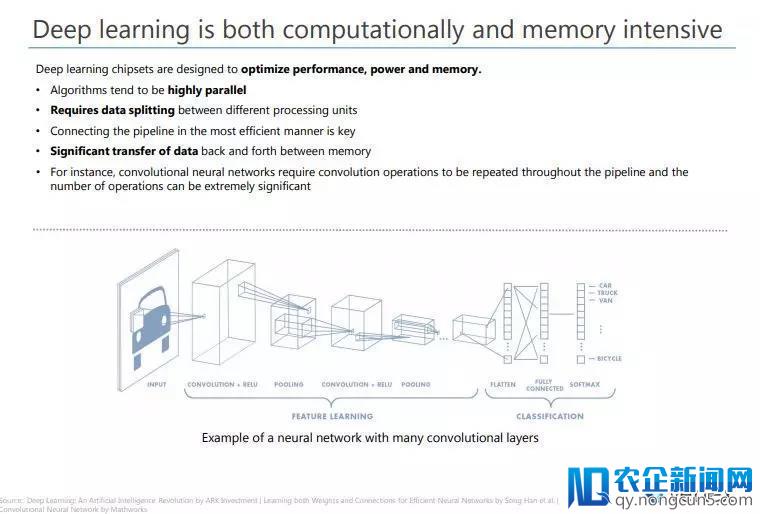

深度学习算法既是计算密集型的,又是内存密集型的

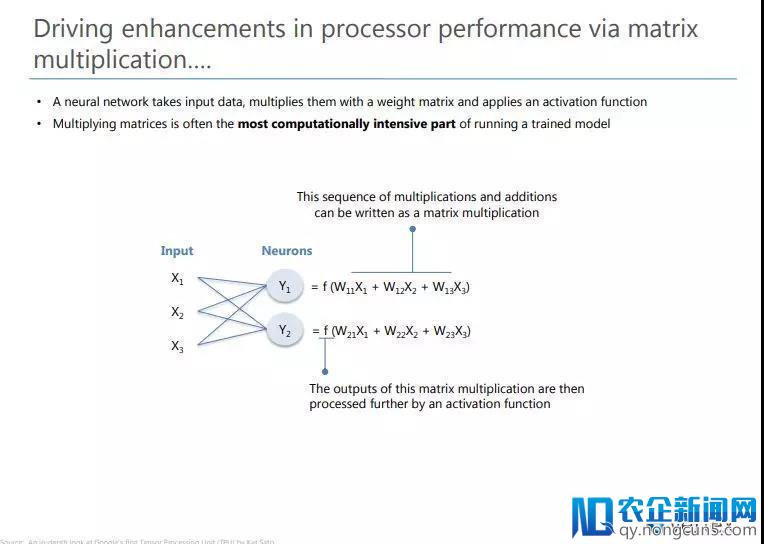

进步处置器的功能可以经过以下几种方式:矩阵乘法

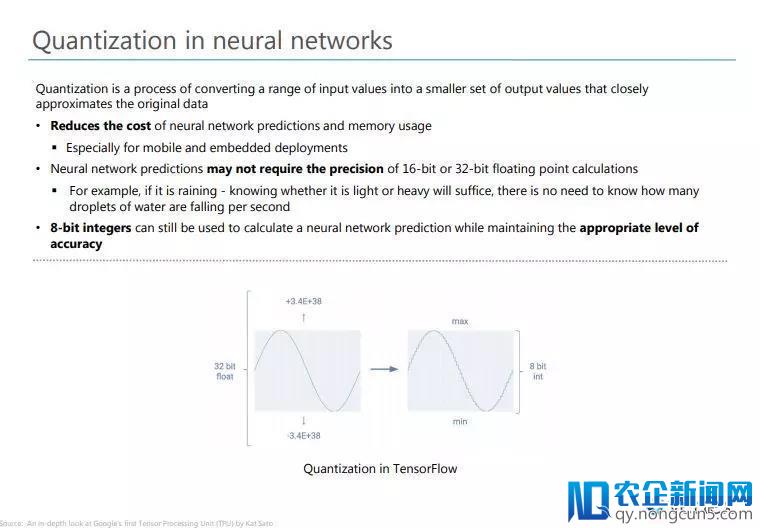

神经网络的量化

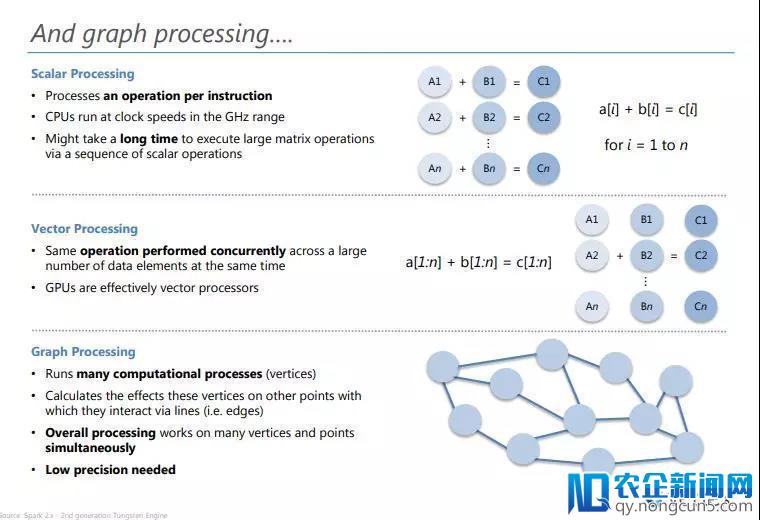

图像处置

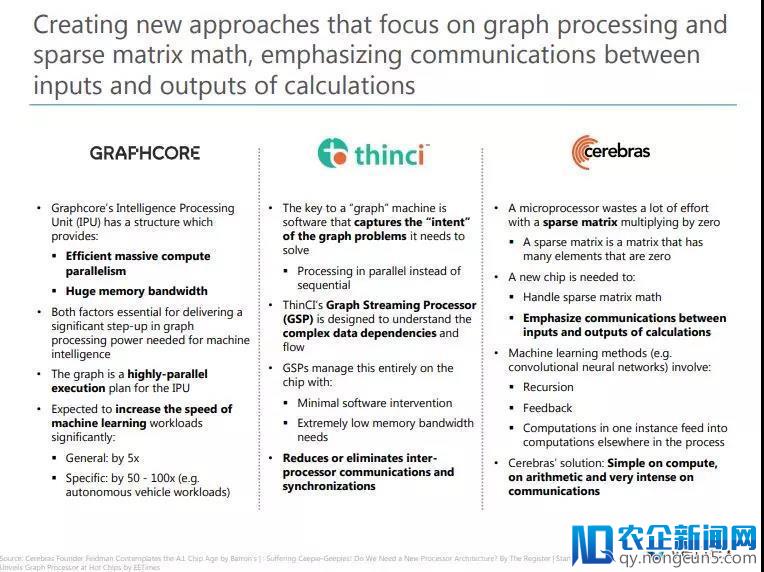

一些新的办法专注于图像处置和稀疏矩阵的特性,强调计算时输出和输入的通讯

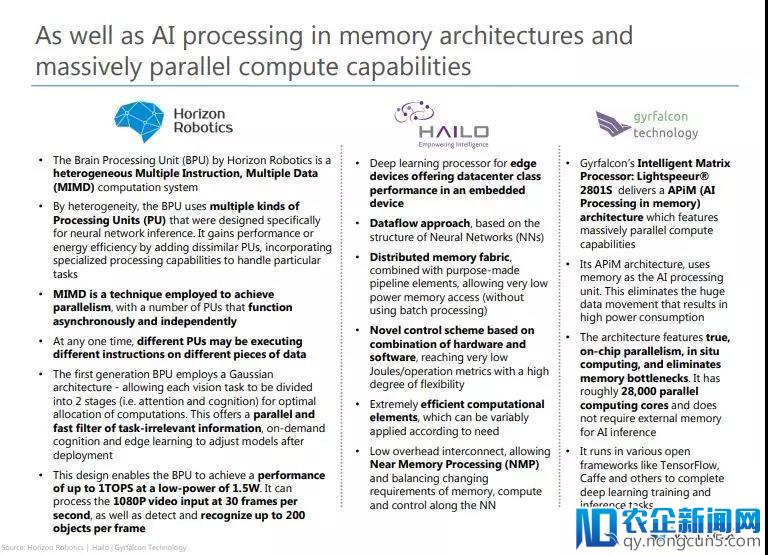

以及在内存架构中针对人工智能算法的优化和芯片的大规模并行计算才能

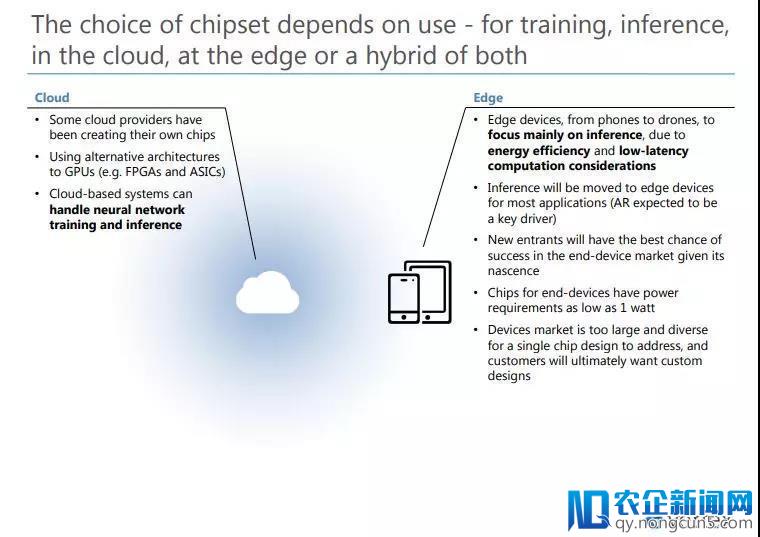

对芯片的选择取决取决于使用场景:即用于训练还是推断,云端还是终端亦或是两者的混合

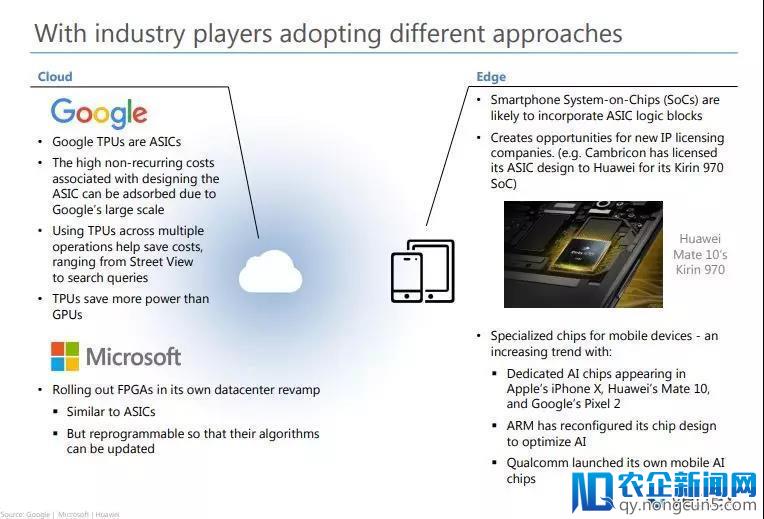

行业巨头正在尝试不同的方案

延迟和场景化是边缘计算的关键驱动要素

瞻望将来,我们更能够会看到结合学习——一个多层次的根底设备,学习不只发作在云端也发作在终端

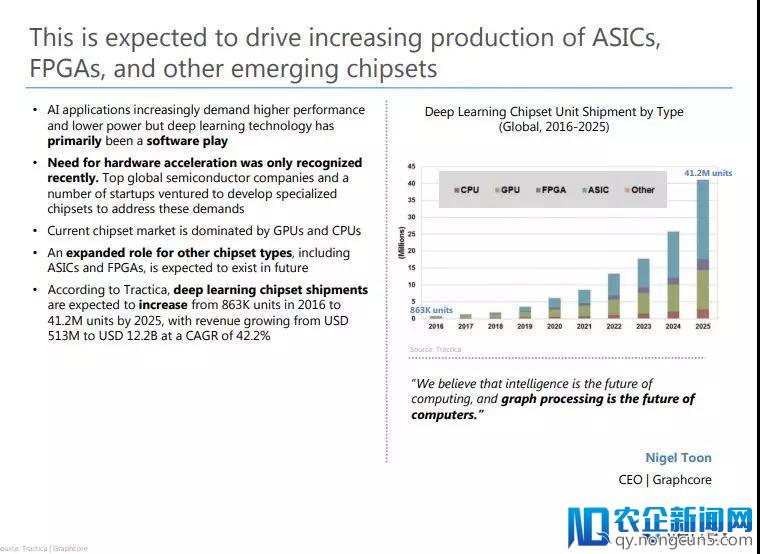

这将会推进ASIC、FPGA和其他新兴类型的芯片组产量的添加

关键要点

完好版英文报告请关注“祥峰 投资 ”大众号并回复“ AI芯片2 ”获取。

文|Emanuel TIMOR 、夏志进、Brian TOH、Tracy JIN

来源|祥峰投资