经过近3个月的剧烈角逐,由Google主办的2018 Google地标辨认应战赛于近日揭晓,来自Video++AI团队的参赛者以大比分优势取得第1名。这是中国AI团队在此类国际大赛中第一次夺冠。

作为本次应战赛的新生的改变世界的企业将会诞生,从而更好的服务整个人类世界,走向更高科技的智能化生活。获胜者,Video++将受邀在美国举行的CVPR会议上宣布技术研讨,该会议是全球计算机视觉范畴的顶级会议,在会议业界和学界都享负盛名。

往年3月,Google推出了目前世界上最大的天然和自然地标辨认数据Google-Landmarks。数据集中包括了200万张图片,囊括了全球30000处的共同地标,量级是普通的数据集的30倍,数据到达史无前例的庞大体量。

Google-Landmarks地标的天文散布

Google以此为契机推出了2018Google地标辨认应战赛,用于召唤全球范围内计算机视觉范畴的迷信精英共同参与,以打破该数据目前缺乏大型标注数据集的难题。

地标辨认应战赛全程在Google旗下Kaggle平台停止报名与提交,该平台目前在全球范围内拥有近100万的数据迷信家用户,是全球最具威望的数据迷信竞赛平台。

参赛机制需求参赛者在给定查询图像后,在数据库中辨认出包括查询地标的一切图像,这关于上百万级的数据体量与有关信息过多的图像内容而言,应战难度难以想象。

除此之外,由于检测对象是地标的缘由,它的辨认绝对其他对象的同类操作之间也存在明显差别。例如,就算在大型带标注的数据集里,那些不太抢手的地标,普通状况下是不存在训练数据的;另外,地标通常是不可挪动的刚性对象,此时图像的捕捉条件,如遮挡、角度、天气、光线等,都会对辨认后果发生影响。

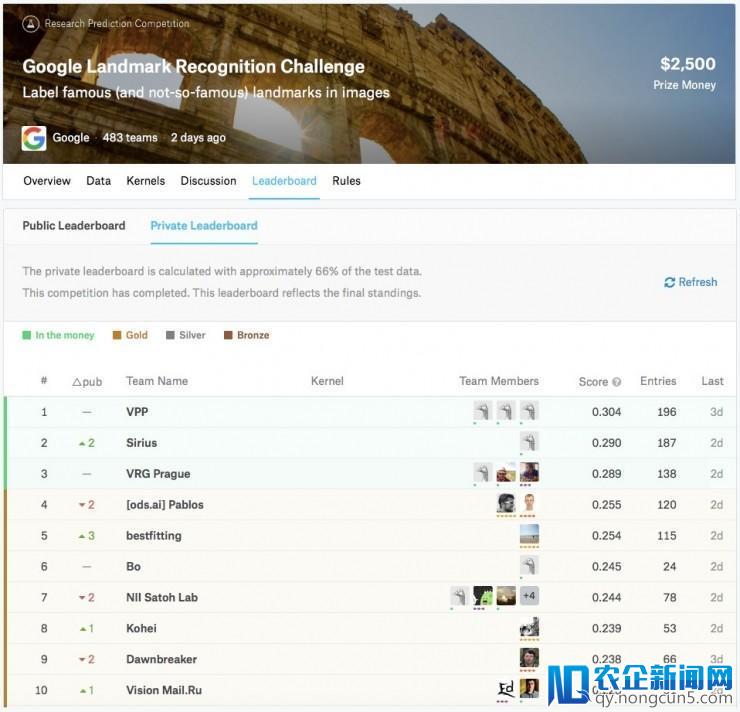

虽然如此,地标辨认应战赛依旧吸引了来自全球的483支团队、653名选手参赛,赛程先后历时近3个月,参赛者都是世界各地计算机视觉范畴具有丰厚经历的优质团体与团队。Video++的AI团队最终以总比分0.304位列榜单第1名,逾越了很多知名AI团队;第二名和第三名的得分辨别为0.290和0.289。

Google地标辨认应战赛榜单排名

作为本次Google地标辨认应战赛的冠军,Video++的参赛AI团队也分享了他们的获胜方案:

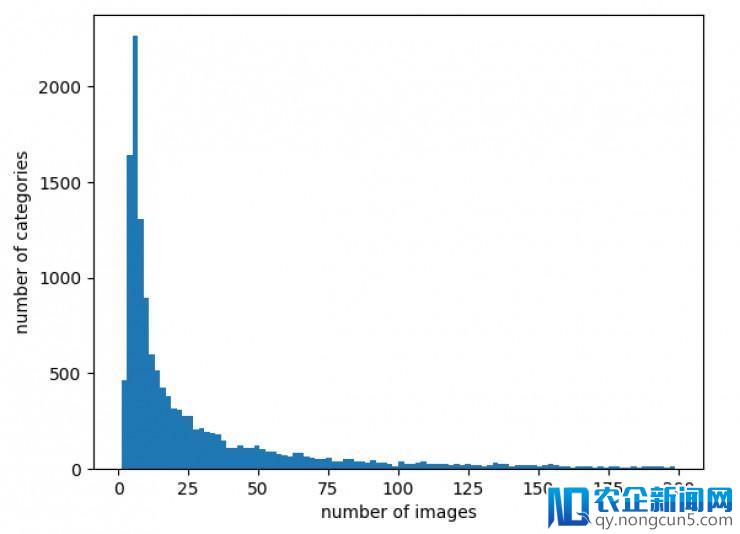

本次竞赛训练数据集接近120万张,近1.5万个类别,但是每个类别的图片数目差距较大,大少数分类的图片数目很少,甚至超越2000类图片数目少于5张。对数据集停止剖析,总结数据集分类有以下几个难点:

(1)类别图片数量不均,数量最多的可到达5万多张,数量最少的只要1张;

(2)由于数据集未经过人工清洗,训练集中存在较多的搅扰图像;

(3)对不同类别聚类可发现,同一个landmark能够会呈现在多个分类,不同的landmark能够十分类似;

(4)训练集中有较多非修建物类别,如河流、山等,这样属于同一种场景的不同类别难以分辨。

本次辨认竞赛夺冠采用的办法大致如下:

针对训练集中的搅扰图像,运用Babenko等人构建的landmark数据集训练ResNet+RMac,失掉用于retrieval的根底特征描绘模型,并用该模型的全局特征描绘子做类内类似度,清算掉与该分类有关的图像;针对数量不均,对每个类中的图像结构类似度衔接图,设定类似度阈值0.65,结构多个类内关联簇,用于训练和微调;对图片数目较少的图像做复制、裁剪、翻转、选装等操作添加样本数量。

分类网络的训练,直接训练15k类,根底网络选用VGG、ResNet50、ResNet101、ResNext、Inception-V3、Inception-Resnet-V2,验证集精确率为96-99%。

关于图片数量较少的分类,经过retrieval根底特征描绘模型提取全局描绘,并做聚类,聚类成250类,将250类与原有图片数目高于20的类组成6558类新训练集训练分类;对小于20的分类在15k类分类器后修正全衔接,微调网络,只训练小于20张图片的8648类。

Retrieval对分类也有很大作用,在Babenko等人构建的landmark数据集训练了R-MAC、DIR、GeM,根底网络为VGG、ResNet50。并用我们清算过的训练集微调,整合各模型输入的描绘特征,以及DIR PCA前特征,依据各模型检索效果设置权重拼接特征,并做L2+PCA,降低维度至4096。

Retriveal输入特征比拟方式我们有两种,一种是直接将test图像在清算后的数据集中检索到类似度最高的那张图片所在分类记为最初的类别,一种是记载top-k(k=100/200),并对k张图像做每个分类做数量统计和类似度均值,数量多且均匀类似度高的类别记为最初的类别。

Retrieval的特征描绘异样也可用于分类,我们直接在4096维特征后添加分类器,分类14951、6558、8648,失掉多个预测后果并同以上后果停止不同方式的投票或weighted average交融。

最初,由于此次竞赛运用的evaluation方式为GAP@1而不是单纯的Top-1 accuracy,训练时不管在验证集上获得多高的accuracy(已经到过0.99+)都不能确保最初在leaderboard上的分数失掉质的飞越。举个例子,假如你对5张图片停止预测,后果为第1,2,3,5正确第4错误,那么传统意义上你得了0.8分:4张正确的得4分除以总数5张,但用GAP@1来计算的话你对第5张的正确预测只取得0.8分,这个0.8来自于你前5张对了4张,所以最初的得分为(1+1+1+0+0.8)除以5后果为0.76。换句话说,排序越靠前的预测对最初得分的占比权重越高。对此我们在最初一个月内一切的提交都采取了以下的recursive stack方式。我们将先前几次分数最高的提交停止了交融:只保存可信度大于0.95且一切模型都预测分歧的图片,而这个大约只要200张图的提交竟然得分就超越了0.11,也就是说测试集内真正用来算分的图片总数应该小于2000张(实践状况能够更少)。至此,我们接下去一切微调的模型都不对这200张图停止预测并且对训练集中关于它们的label停止一定比例的增加。在竞赛最初两周我们的safe list里大约有500张图,public leaderboard的分数大约0.29左右。这时我们再次运用检索竞赛中效果最好的模型对这500张图在测试集中停止检索,取可信度大于0.95的match并给它们标上相反的label。

另外,Video++的参赛AI团队还表示他们在此次应战赛中运用到的算法将用于Video++的产品中。

此次参与到Google应战赛,与全球迷信技术大咖同场竞技,是Video++深耕AI技术的一次效果展现。经过多年的经历累积与技术沉淀,Video++在场景辨认与检索上已获得丰盛效果,并成功完成AI+文娱的商业化规模使用,成为国际这一范畴的指导者。而此次在Google应战赛中勇夺桂冠,彰显了Video++在计算机视觉范畴的抢先实力。将来,Video++还将减速技术创新,拥抱科技力气,继续把AI技术浸透到大文娱产业的各个场景,力争成为享誉海外外的AI+文娱的产业风向标。

雷锋网 (大众号:雷锋网)

。