雷锋网 AI 科技评论按:自从 Ian Goodfellow 等人发现经过纤细修正的正常照片就可以成为能骗过神经网络图像分类器的「对立性样本」 以来,这种景象就惹起了越来越多研讨者的关注,相关的研讨效果也越来越多。

之前我们就报道过去自 UIUC 的研讨效果:「 对立性样本是纸老虎,一出门就不好使 」,标明作为电子文档时可以随便骗过图像分类器的对立性样本,打印成实物、经过镜头拍摄之后效果就大大削弱;另一项 OpenAI 的研讨则显示出, 可以修正出不同强度的对立性样本 ,修正水平越高就对视角变换越鲁棒、越可以波动骗过火类器,不过在人眼看来也就越发不自然。

上面这篇来自 UC 伯克利大学人工智能实验室(BAIR)的研讨博客(兼论文预告)进一步研讨了如何骗过物体检测器,是对立性样本研讨方向上的另一个新效果。雷锋网 (大众号:雷锋网) AI 科技评论对其停止了全文编译。

深度神经网络(Deep Neural Networks, DNNs)使得少量的使用范畴取得了极大提高,包括图像处置、文本剖析和语音辨认。DNNs 也正逐步成为许多信息物-理零碎的一个重要组成局部。例如,无人驾驶汽车的视觉零碎会应用 DNNs 来更好地辨认行人、车辆和路途标志。但是,近期的研讨标明,DNNs 易受对立样本攻击:在输出中小心肠添加天然对立性搅扰可以误导被攻击的 DNN 零碎,使其在运用时不能正确对人、交通工具和路标分类。这些对立样本在理想世界中会引发团体和社会的平安隐忧。比方,带对立式性扰动的输出会误导自动驾驶车辆的感知零碎,使其错误地对路标分类,从而带来潜在的灾难性结果。

现有一些技术可用来生成对立样本以及进攻它们。在这篇博客中,我们扼要地引见下最先进的生成数字对立样本的算法,然后讨论我们在各种环境条件下基于真实物体生成对立样本的算法。我们将提供我们为目的检测器生成真实对立样本所做努力的最新状况。

数字对立样本

在白盒条件下,生成对立样本曾经提出了许多不同的办法,此时对立器可以晓得深度学习网络一切信息。白盒条件下假定存在一个弱小的对立器,且可以协助将来开发万无一失的进攻零碎打下坚实根底。这些办法有助于了解数字对立样本。

Goodfellow 等提出了疾速梯度法,使用损失函数的一阶近似来构建对立样本。

也有人提出基于优化的办法来为针对性攻击创立对立性搅扰。特别地,这些攻击结构了一个目的函数,其求解进程寻求最大化输出数据的真实标签与攻击者希冀的目的标签之间的差别,同时在某种类似度下最小化输出数据之间的差别。在计算机视觉的分类成绩中,一个常用的度量办法是输出向量的 L2 范数。通常地,具有较低 L2 间隔的输出样本之间相互接近。因而,计算出对人眼来说十分类似但对分类器来说十分却不同的输出数据是可行的。

近期的研讨任务验证了数字对立样本的黑盒迁移才能,即在黑盒条件下生成对立样本也是可行的。这些技术触及在一个白盒下的已知模型上生成对立样本,然后到待攻击的未知模型上测试它们。

实物对立样本

为了更好天文解这些软弱性, 有少量的任务是研讨物质世界中对立样本是如何影响 DNNs 的。

Kurakin 等的研讨标明经过智能手机摄像头去分类打印在纸上的对立样本,容易被错分。Sharif 等人经过在人脸眼镜框帧上添加对立性搅扰攻击了人脸辨认零碎。他们的任务标明在绝对波动的真实条件下,巨大的姿势变化、摄像头间隔或角度变化、以及光照变化,都可以成功地停止实物攻击。这为了解波动环境下实物对立样本奉献了一个风趣的解释。

我们近期的研讨「深度学习模型中鲁棒的实物攻击」曾经展示出了对分类器的实物攻击。合理的下一步是,我们对检测器展开攻击。这些计算机视觉算法辨认出一个场景中的相关物体并预测一个包围框,表示物体的地位和类别。与分类器相比,检测器更难诈骗,由于它们在预测时处置整个图像且运用上下文信息(例如目的物体在场景中的方向和地位)。

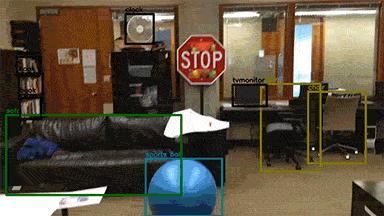

YOLO 检测器是一个盛行的、实时的先进算法,我们展现在其上停止实验的实物对立样本。我们的例子以贴纸搅扰的方式放在真实的停车路标上。上面的图片是我们的实物对立搅扰的例子。

我们还执行了静态测试,经过记载一个视频来测试检测器的功能。从视频中可以看出,YOLO 网络在简直一切的帧上都不能辨认出停车路标。假如一个真实的自动驾驶车辆在路面行驶,路过一个带对立性特征的制止通行路标,那么它将看不到停车路标,从而能够在穿插路口招致车祸。我们创立的搅扰对间隔和角度变化鲁棒—-这是无人驾驶场景中最罕见的变化要素。

静态测试 1:YOLO 辨认带有对立性贴纸搅扰的停车路标

静态测试 2:YOLO 辨认带有对立性贴纸搅扰的停车路标

更风趣的是,为 YOLO 检测器生成的真实对立样本异样也能诈骗规范的 Faster R-CNN 网络。我们的视频包括一个在 Faster R-CNN 上停止的实物对立样本的静态测试。由于这是在 Faster R-CNN 上停止的黑盒攻击,其不如在 YOLO 案例中那样成功,这是预期的后果。我们置信,添加其他技术(如集成训练),黑盒攻击会愈加高效。此外,特别为 Faster R-CNN 优化一个攻击器能发生更好的后果。我们正在写一篇论文,探求这些攻击的更多细节。上面的图片是 Faster R-CNN 不能辨认出停车路标的例子。

静态测试 3: 为 YOLO 生成的真实对立样本对 Faster R-CNN 做黑盒迁移测试

在两种案例中(YOLO 和 Faster R-CNN),仅仅当摄像头离停车路标十分近时才干检测出来(大约 3 至 4 英尺)。在真实场景中,这个间隔关于车辆来说太近了从而不能采取无效的纠正措施。请持续关注我们行将宣布的论文,其包括了关于算法的更多细节和在先进的物体检测器上的实物搅扰的后果。

攻击算法概述

这个算法是基于我们后期分类器攻击的任务。实质上,我们采用一个优化办法来生成对立样本。但是,我们的实验经历标明,为检测器发生鲁棒的实物对立样本相比诈骗分类器需求模仿一套更大的不时变化的真实环境。这是能够是由于检测器在预测时需求思索更多的上下文信息。算法的次要特性包括指定真实环境模仿中序列的才能,以及指定平移不变性的才能。即一个搅扰无论目的物体位于场景中的哪个地位都应该是无效的。由于一个物体可在场景中自在地挪动,这取决于察看者的角度,不为这种状况优化的搅扰很能够在物体挪动时生效。针对该课题,我们行将出来的论文会包括该算法的更详细信息。

潜在的进攻

给定这些实物对立样本和数字对立样本,能够的进攻办法已有普遍研讨。在这些办法当中,有几品种型的对立训练办法是很无效的。Goodfellow 等初次提出采用对立训练作为进步 DNNs 鲁棒性的无效办法,而 Tramer 等将它扩展到对立学习。Madry 等经过对立样本的迭代训练也提出了鲁棒的网络。要停止对立训练,就需求一个更大的对立样本数据集。此外,集成训练标明,假如这些对立样原本自不同的模型,那么就能使得进攻愈加鲁棒。集成对立训练的益处在于提升对立样本的多样性,使得模型能搜索整个对立样本空间。异样,也存在几种不同的进攻模型,但是 Carlini 和 Wagner 表示没有任何现有进攻办法是鲁棒的,即便是自顺应攻击。

总之,为了找到进攻这些对立样本的最佳进攻战略,我们还有很长一段路要走,我们将满怀等待地探究着这个冲动人心的范畴。

via: BAIR ,雷锋网 AI 科技评论编译、

相关文章:

UIUC最新研讨:对立性样本是纸老虎,一出门就不好使!

OpenAI最新研讨:“对立样本”能随便黑掉AI零碎,如何抵挡?

UIUC说对立样本出门会生效,被OpenAI怼回来了!

。