参与:陈韵竹

近日,Medium上一篇题为《AI in 2018 for developers》的文章,针对机器学习使用于业界的机器学习开发人员,依据2017年的人工智能范畴的最新和最严重停顿,对2018年的停顿做了瞻望。

大家好,又见面了!在上一篇文章中,我谈到了本人关于研讨范畴的看法,即哪些研讨范畴正在成熟且能在往年开展壮大。持续从事研讨当然很棒,但是,肯定还有一些 人工智能 范畴在 2017 年曾经成熟、现已预备投入大规模使用了。这就是本文的主题——我想分享的是那些曾经开展得足够好的技术。

它们已能使用于你当下的任务中,甚至你能借此创业。重要提示:这是一份涵盖人工智能范畴、算法和技术的清单,且它们都能立刻投入运用。例如,你可以在文中看到工夫序列剖析,由于深度学习正在迅速取代信号处置范畴之前的先进技术。但是,文中并没有提到强化学习(虽然它听起来更酷),由于在我看来它目前还不能投入工业使用。不过强化学习是个很了不起的、正在生长的研讨范畴。

此外,我想提示你,这是一个包括三篇文章的系列文章之一,其中辨别从三个角度分享了我关于明年人工智能范畴会发作什么的看法:

- 作为正在推进范畴开展的机器学习研讨者(https://blog.goodaudience.com/ai-in-2018-for-researchers-8955df0caaf9)

- 作为将机器学习使用于业界的机器学习开发人员(本文)

- 作为生活在这个新世界中的普通人

希望你能挑选合适本人的文章停止阅读!

另外,我在此并不谈判论图像辨认和复杂的计算机视觉,你们曾经在这些范畴努力多年啦。

GAN 和虚伪产物

即便几年前就有了生成对立网络(GAN),我对此一度十分疑心。几年过来了,即便我看到 GAN 在生成 64×64 图像方面的宏大提高,我仍坚持着疑心。后来我阅读了一些数学方面的文章,文中提到 GAN 并不真正学习散布,我的疑虑愈发明显。不过往年发作了一些改动。首先,风趣的新型构造(例如 CycleGAN)和数学改良(Wasserstein GAN)吸引我在理论中尝试了 GAN,它们或多或少都任务得不错。在接上去的两个使用中,我彻底改动了态度,确信我们可以且必需应用它们来生成事物。

首先,我十分喜欢英伟达关于生成全高清图像的研讨论文,而且它们看上去确实很真实(相比于一年前 64×64 的诡异面孔而言):

不过,我最喜欢(作为一个完满的少年梦想使用)且被深深震撼的是生成虚伪色情片:

- AI-Assisted Fake Porn Is Here and We’re All Fucked:https://motherboard.vice.com/en_us/article/gydydm/gal-gadot-fake-ai-porn

我还留意到许多游戏行业的使用,比方应用 GAN 生成景观、游戏配角甚至是整个世界。此外,我觉得我们必需对新的造假程度惹起留意——包括你亲友的虚伪色情片和线上完全虚伪的团体。(能够不久之后线下也有?)

全部神经网络的独有形式

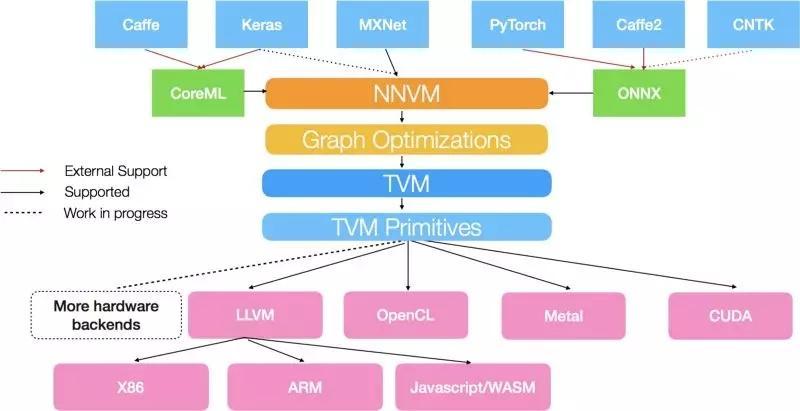

古代开展的成绩之一(不只局限于人工智能产业)是,我们有几十个不同的框架来完成异样的东西。明天。每个做机器学习的大公司都必定有本人的框架:谷歌、Facebook、亚马逊、微软、英特尔、甚至是索尼和 Uber。此外,还有很多开源的处理方案!在一个复杂的人工智能使用中,我们也希望运用不同的框架:例如,计算机视觉通常用 Caffe2、自然言语处置常用 PyTorch、引荐零碎常用 Tensorflow 或 Keras。把这些框架全部兼并起来需求消耗少量的开发工夫,并且会让数据迷信家和软件开发者无法集中留意力完成更重要的义务。

处理方案必需是一个无独有偶的神经网络方式。它需求能从任何框架中容易地取得,必需由开发人员轻松部署,并能让迷信家随便地运用。在这个成绩上,往年呈现了 ONNX:

实践上,它只是非循环计算图的复杂格式,但却在实践中给了我们部署复杂人工智能处理方案的时机,而且我团体以为它十分具有吸引力——人们可以在像 PyTorch 这样的框架中开发神经网络,无需弱小的部署工具,也不需求依赖 Tensorflow 的生态零碎。

各类 Zoo 激增

对我来说,三年后人工智能界最让人兴奋的东西是 Caffe Zoo。事先,我正在做计算机视觉的相关任务,试遍一切模型,并反省它们如何任务、后果如何。稍后,我将这些模型使用于迁移学习或特征提取器。最近,我运用了两种不同的开源模型,相似大型计算机视觉流程中的一局部。这意味着什么?这意味着现实上没有必要训练本人的网络,例如 ImageNet 的对象辨认或地点辨认。这些根底的东西可以下载并拔出到你的零碎当中。除了 Caffe Zoo 之外,其他框架也有相似的 Zoo。不过,让我感到惊奇的是,你可以仅在你的 iPhone 中拔出计算机视觉、自然言语处置甚至减速度计信号处置的模型:

- likedan/Awesome-CoreML-Models:https://github.com/likedan/Awesome-CoreML-Models

我以为,这些 Zoo 只会越来越多,将 onNX 这类生态零碎的呈现思索在其中,并停止集中化(也会由于机器学习区块链使用而招致分散化)。

自动机器学习替代流程

设计神经网络构造是件苦楚的义务——有时分你可以经过添加卷积层取得不错的后果;但是大少数时分,你需求运用超参数搜索办法(如随机搜索或贝叶斯优化)或是直觉细心设计构造的宽度、深度和超参数。在计算机视觉范畴,你至多可以调整在 ImageNet 上训练的 DenseNet。但假如你在某些 3D 数据分类或多变量工夫序列使用中任务,这一点将尤其困难。

运用其他神经网络从头生成神经网络构造的尝试有很多,但对我而言最棒、最明晰的是近期 Google Research 的停顿:

- AutoML for large scale image classification and object detection:https://research.googleblog.com/2017/11/automl-for-large-scale-image.html

他们运用 AutoML 生成的计算机视觉模型,比人类设计的网络任务的更快、更好!我置信,很快就会有许多关于这个话题的论文和开源代码。我以为,会呈现更多博文和初创公司,通知我们「人工智能所发明的人工智能学习了其别人工智能,它可以……」,而不是「我们开发了一团体工智能,它可以……」。至多,在我的项目中我会这样做。我也置信不是只要我一团体这样做。

智能堆栈正式化

在这个概念上,我阅读了很多 Anatoly Levenchuk 的博文。他是俄罗斯零碎剖析师、教练,同时热衷于人工智能范畴。在下图中,你可以看到所谓「人工智能堆栈」的实例:

http://www.tvmlang.org/2017/10/06/nnvm-compiler-announcement.html

它不只包括机器学习算法和你喜欢的框架,还有着更深的层次。而且在每个层面,都含有本身的开展和研讨。

我以为,人工智能开展产业曾经足够成熟,从而能拥有更多不同的专家。在团队中,仅有一名数据迷信家远远不够——你需求不同人员从事硬件优化、神经网络研讨、人工智能编译、处理方案优化和消费施行等方面的任务。在他们之上必需有不同的团队指导、软件架构师(为上述每个成绩辨别设计堆栈)以及管理人员。我已经提过这个概念,希望未来人工智能范畴的技术专家可以不时生长(对那些想成为人工智能软件架构师或技术引领者的人而言——你需求晓得该学什么)。

基于语音的使用

人工智能所能处理的精确率可达 95% 以上的成绩其实十分少:我们可以将图像辨认分类到 1000 个类别,可以判别文本的正负面性、当然也能做一些更复杂的事情。我以为,还有一个范畴将因人工智能派生的上千个使用发作动乱:那就是语音辨认和生成。现实上,一年前 DeepMind 发布 WaveNet 之后这个范畴还开展得不错。但是明天,多亏了百度的 DeepVoice 3 和最近在 Google Tacotron2 的开展,我们曾经走远:

- Tacotron 2: Generating Human-like Speech from Text:https://research.googleblog.com/2017/12/tacotron-2-generating-human-like-speech.html

这个技术很快就会发布在开源代码中(或着被一些聪明的人复制),而且每团体都能以十分高的精确率辨认语音并生成它。这会带来什么呢?更好的公家助理、自动阅读器、会谈转录机……当然还有作虚伪声响产品。

愈加智能化的机器人

我们明天所看到的机器人都有一个很大的成绩——其中 99% 基本不基于人工智能,只是硬编码而已。由于我们认识到,我们不能用上百万个对话的留意力训练某些编码-译码器 LSTM,从而取得智能零碎。这就是为什么 Facebook Messenger 或 Telegram 中的绝大局部机器人都只要硬编码命令,至少拥有一些基于 LSTM 和 word2vec 的句子分类神经网络。但是,古代先进的 NLP 有点超出了这个程度。只需求看看 Salesforce 做出的风趣研讨就能体会这一点:

- AI Research – Salesforce.com:https://www.salesforce.com/products/einstein/ai-research/

他们正在构建与数据库相连的 NLP 接口,克制古代编码-译码器的自动回归模型,不只对文字或句子停止嵌入训练,而将范围扩展到了字符嵌入训练。此外,还有一个应用强化学习停止 ROUGE 分数 NLP 优化的风趣研讨:

https://www.salesforce.com/products/einstein/ai-research/tl-dr-reinforced-model-abstractive-summarization/。

我置信,随着这些开展,我们至多能提升机器人程度。它们能检索更多智能信息、停止命名实体辨认,而且很能够在某些封锁范畴充沛深度学习驱动机器人。

先进的序列剖析

除 Salesforce 外,第二个被低估的机器学习研讨实验室是 Uber 的人工智能实验室。前段工夫,他们宣布了一篇博客,展现了对工夫序列的预测办法。老实说这让我有点受宠若惊,由于在我的使用中根本上也用了异样的办法!看看吧,这就是将统计特征和深度学习表示相结合的实例:

- Engineering Extreme Event Forecasting at Uber with Recurrent Neural Networks:https://eng.uber.com/neural-networks/

假如你需求更多振奋人心的实例,请用 34 层一维 ResNet 尝试诊断心律正常。最棒的局部无疑是其功能——它不只优于一些统计模型,甚至超越了专业心脏病专家的诊断!

最近,我从事的大局部就是深度学习的工夫序列剖析。我可以亲身证明神经网络任务得十分好,你能取得优于「黄金规范」5-10 倍的功能。它真的能行!

逾越内置的优化

我们如何训练神经网络?说假话,我们大少数人只是运用相似「Adam()」函数或是规范学习率。一些聪明的人选择最适宜的优化器,并调整和调度学习率。我们总是低估「优化」这一主题,由于我们只需按下「优化」按钮,然后等候网络收敛就半途而废了。但是,在这个计算才能、存储和开源方案都大多相反的状况下,优胜者往往运用着与你相反的亚马逊实例,却能在 Tensorflow 模型中用最短的工夫失掉最佳的功能——这一切都是优化的功绩。

- Optimization for Deep Learning Highlights in 2017:http://ruder.io/deep-learning-optimization-2017/index.html

我鼓舞大家看看下面 Sebastian’s Ruder 的博文,其中谈到了 2017 年最新的规范优化器改良方案,以及其他十分有用的改善办法。你可以立刻将其运用起来。

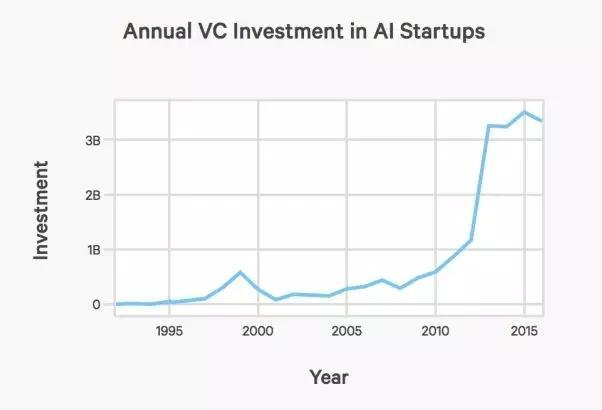

大肆宣传的全体下降

cdn.aiindex.org/2017-report.pdf

在阅读前文后,你能从这张图片中发现什么?思索到许多开源工具和算法的发布,开发有价值的新东西并从中获取很大利润并不容易。我以为,对相似 Prisma 这样的初创公司而言,2018 年并非最好的一年——将会有太多的竞争对手和「聪明人」想分一杯羹。他们可以将如今的开源网络部署在挪动使用顺序中,并称其为「创业」。

往年,我们必需专注于根底的事情,而不是很快获利——即便关于某些有声书初创公司而言,我们方案用 Google 的 Ratacon 停止语音辨认,但这也并非一个复杂的网络效劳,而是与协作同伴携手的商业形式,同时也是吸引投资的商业模型。

总结

简而言之,有几种技术曾经可以被用于实践产品:工夫序列剖析、GAN、语音辨认、自然言语处置范畴的局部开展。我们不应该再设计根底的分类或回归架构,由于 AutoML 会帮我们做这个。经过一些优化改良,我希望 AutoML 可以比以前运转得更快。此外,运用 onNX 和各种模型 Zoo 能让我们仅用几行代码将根本模型注入到使用顺序当中。我以为,制造人工智能为根底的使用,在目前先进的技术程度来说不是难事,而且对整个行业而言并无害处!关于研讨范畴的开展,可以查阅我以前的文章。不久后,我将发布「2018 人工智能开展趋向」系列的最初一篇文章,其中将引见人工智能如何影响「普通人」的生活。

原文链接:https://medium.com/@alexrachnog/ai-in-2018-for-developers-2f01250d17c