大众号/新智元

AI决策进程的黑匣子成绩不断是AI范畴最大的担忧之一,但近期黑匣子决策成绩似乎被破解。来自加州大学伯克利分校、阿姆斯特丹大学、Facebook AI Research团队的研讨人员创立出一个AI自我解释模型,该模型可使AI在答复成绩时指出成绩对应的证据,在答复相关图像成绩时,其可以为其决策提供自然言语理由并指出图像显示证据。

来自加州大学伯克利分校、阿姆斯特丹大学、Facebook AI Research团队的研讨人员创立出一个AI自我解释模型,该模型可使AI在答复成绩时指出成绩对应的证据,在答复相关图像成绩时,其可以为其决策提供自然言语理由并指出图像显示证据。

“黑匣子”变得通明,这是一件大事。

在许多环境中,深度模型既无效又可解释;先前可解释的模型是单峰模型,提供了基于图像的留意权重的可视化或基于文本的预先理由的生成。

这次的研讨提出了一种多形式的解释办法,并且以为这两种形式提供了互补的阐明性优势。

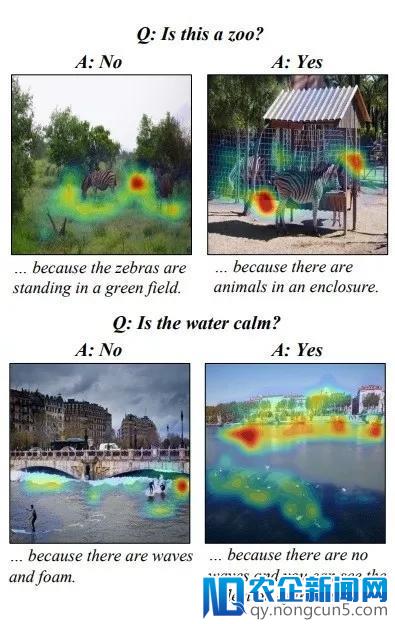

团队搜集两个新的数据集来定义和评价这个义务,并提出一个新的模型,可以提供结合文本感性和可视化生成。我们的数据集定义了活动辨认义务(ACT-X)和视觉成绩解答义务(VQA-X)的分类决策的视觉和文本理由。

在数量上标明,运用文本解释停止培训不只可以发生更好的文本理由模型,还可以更好地定位支持决策的证据。我们还定性地展现了视觉解释比文本解释更具洞察力的状况,反之亦然,支持我们的论点:多形式解释模型提供了逾越单峰办法的显着优势。

VQA-X定性后果:关于每个图像,PJ-X模型提供了答案和理由,并指出了该理由的证据。

弄清楚为什么一个神经网络做出它所做的决议是人工智能范畴最大的担忧之一。正如它所称的那样,黑盒成绩实践上使我们不能置信AI零碎。

像人类一样,它可以“指出”它用来答复成绩的证据,并且经过文本可以描绘它如何解释证据。它的开发旨在答复那些需求九岁小孩均匀智力的成绩。

这是人们第一次创立了一个可以用两种不同方式解释本人的零碎:

我们的模型是第一个可以为决策提供自然言语理由并指向图像中的证据的人。

研讨人员开发了AI来答复关于图像的复杂言语查询。它可以答复关于给定场景中的对象和举措的成绩。它经过描绘它看到的内容并突出显示图像的相关局部来解释它的答案。

它并不总是让事情正确。在实验进程中,人工智能感到困惑,无法确定一团体能否在浅笑,也无法分辨出一团体在运用吸尘器的人和一个正在运用吸尘器的人之间的区别。

但是,这是一个重点:当电脑呈现成绩时,我们需求晓得缘由。

为了到达任何可权衡的成熟度,AI的范畴需求调试,错误反省和了解机器决策进程的办法。神经网络开展并成为我们数据剖析的次要来源时尤其如此。

为人工智能展我们也正在做着心目中属于未来的事业,那就是通过互联网金融创新,不断完善人与金融、货币之间的关系,让所有人都能享受到最好的金融服务 。现其任务并以内行人员的角度解释本人,这是一个宏大的飞跃,可以防止每团体似乎都很担忧的机器人启示。

论文地址:https://arxiv.org/pdf/1802.08129.pdf