大众号/OReillyData

在本文中我分享了一些幻灯片和笔记。它们来自于我在2017年12月新加坡Strata 数据会议上宣布的讲话,针对积极部署机器学习驱动产品的公司,这些材料提供了一些建议。在过来几年中,数据社区不断专注于用于数据搜集的根底架构战争台,这其中包括了弱小的数据管线,以及高度可扩展的、用于数据剖析的存储零碎。 据linkedIn最近的一份报告显示,『机器学习工程师』和『数据迷信家』占据了新兴职业岗位的前两名地位。少量公司开端将数据根底架构推向实战,机器学习将在将来几年变得愈加普遍。

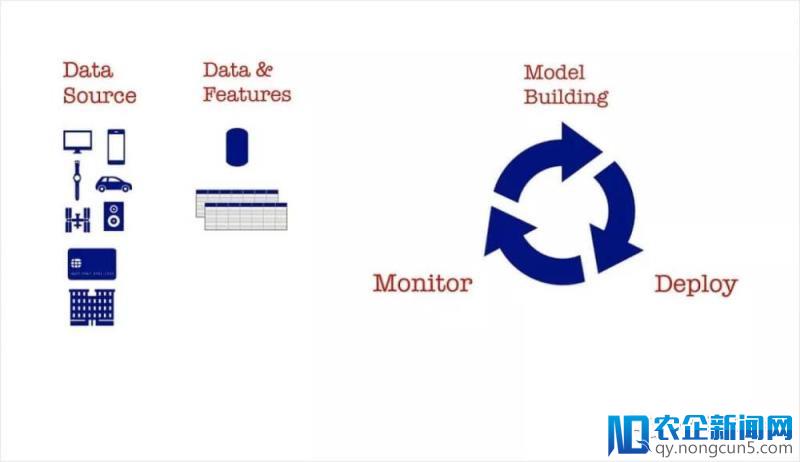

图1. 来自Ben Lorica的幻灯片

随着越来越多的公司开端在产品,工具和业务流程中运用机器学习,我们复杂引见一下模型构建,模型部署和模型管理的流程。 现实证明,一旦树立模型,在消费环境中对其停止部署和管理是需求工程技巧的。往年的早些时分,我们留意到,一些公司曾经为担任在消费环境维护机器学习模型的人员发明了一个新的角色——机器学习(或许深度学习)工程师。

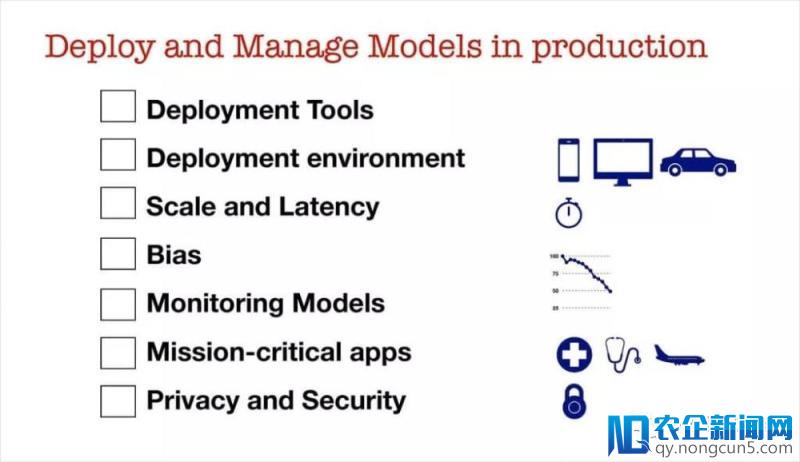

图2. 来自Ben Lorica的幻灯片

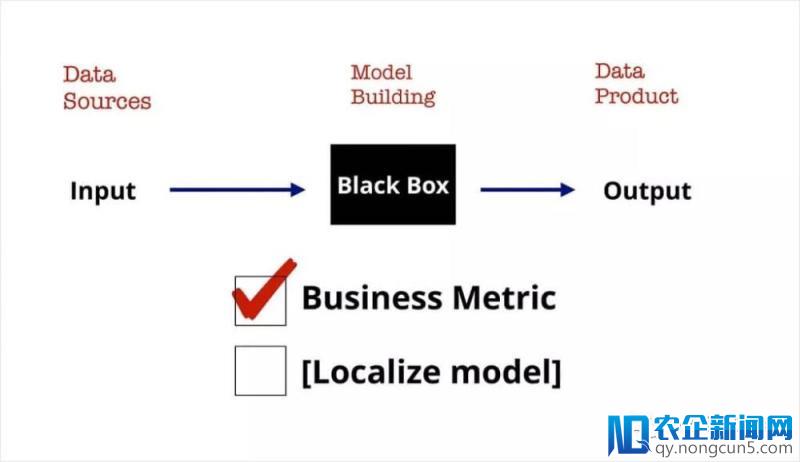

以后盛行的机器学习库和相似『notebook』的工具,使构建模型变得日益复杂。新的数据迷信家需求确保他们了解业务成绩,并在这种根底上针对业务成绩对模型停止优化。 在相似西北亚这种文明多元化地域,由于东盟(ASEAN)国度的状况和场景有所不同,需求对模型停止本地化。

图3. 来自Ben Lorica的幻灯片

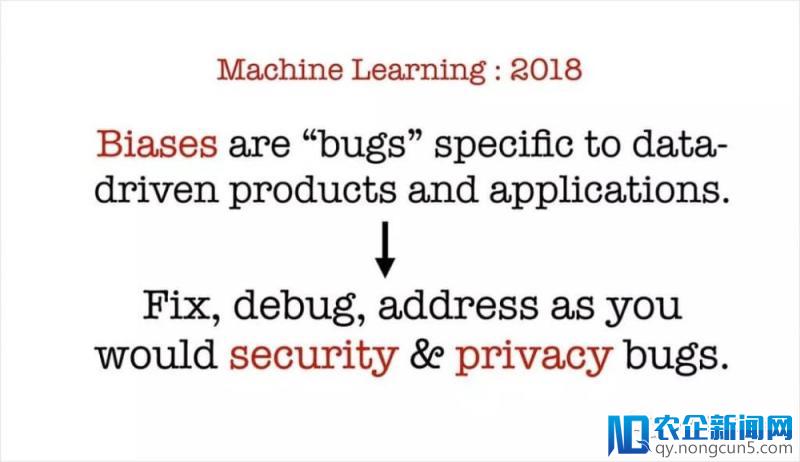

瞻望2018,人们关于算法成见所形成的影响、算法的公道性/通明度的重要性渐渐有所认知,这意味着,数据迷信家要做的绝不只仅只是复杂地优化业务目标。我们需求仔细看待这些成绩,就像我们投入真金白银来处理数据平安、数据隐私成绩一样,来处置这些成绩。

图4. 来自Ben Lorica的幻灯片

虽然不存在一张八面玲珑的清单,可以让人零碎性地处理有关公道性,通明度和问责制度的相关成绩,不过一个好音讯是,机器学习研讨社区曾经为建模人员提供了一些建议和老手起步指南。让我举几个复杂的例子。

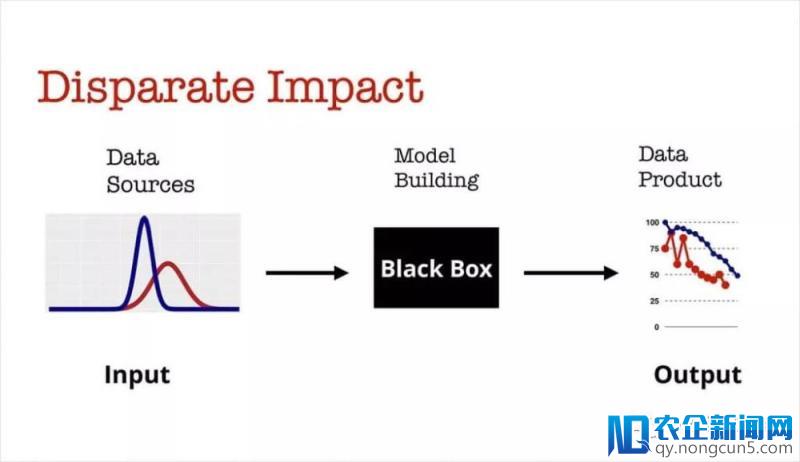

假定,在机器学习模型里你曾经有了一个重要的特征(比方说,与特定地点的间隔)。不过在样本总体中,存在一些分组(比方,高支出/低支出分组),在不同的分组中,特征出现出全然不同的散布。能够发作的事情是,你的模型,关于这两个群领会发生差别性影响。 一个相关的例子是Staples推出的在线定价模型:该模型基于用户不同的天文地位,给出了不同的建议价钱。

图5. 来自Ben Lorica的幻灯片

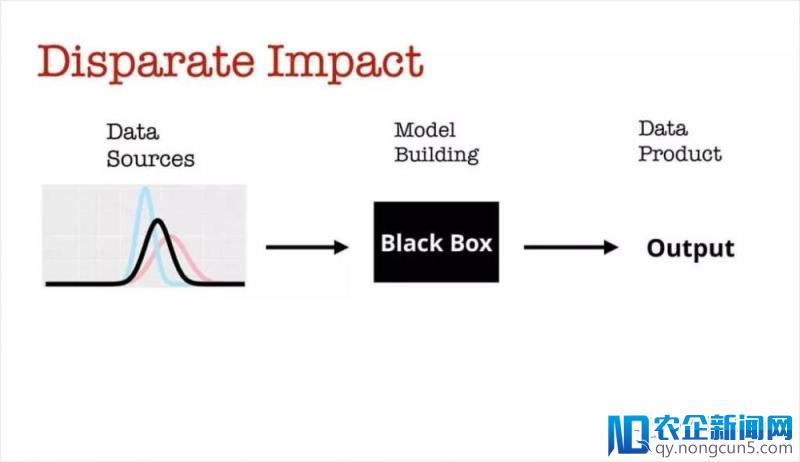

2014年,一组研讨人员提供了一种数据重整化办法来消弭差别性影响:

图6. 来自Ben Lorica的幻灯片,参考链接

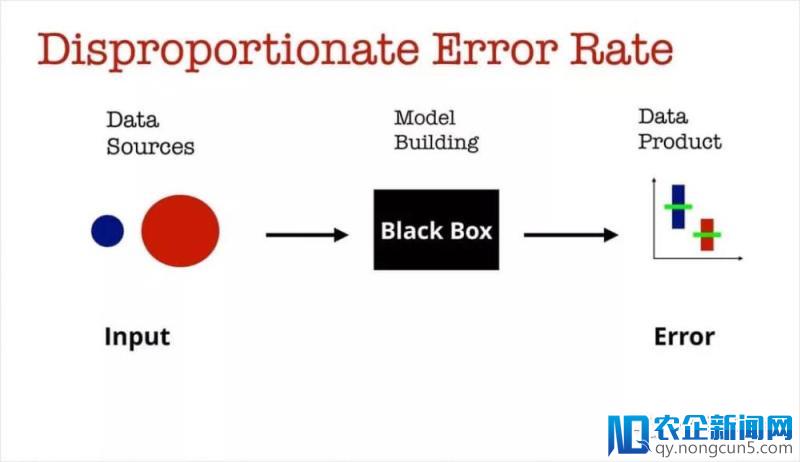

另一个例子与预测错误有关:一旦我们对某个错误概率感到称心,我们是不是曾经做好预备将我们的模型部署到消费环境中去了?思索一下在医疗护理项目中运用机器学习模型的状况:在模型构建进程中,与老年人(蓝色)相比,千禧一代(白色)的训练数据样本量大得多。正确率有一种和训练样本大小正相关的倾向,因而,关于老年人预测的错误概率就比对千禧一代年老人的预测错误率要高。

图7. 来自Ben Lorica的幻灯片

针对相似的状况,一些研讨者引入了一个名为『等几率』的概念,缓解不同类间错误率不等的状况,保证不同组的『真阳性率』(True Positive Rate)接近。参考这篇论文,并结合交互式可视化方案停止阅读。

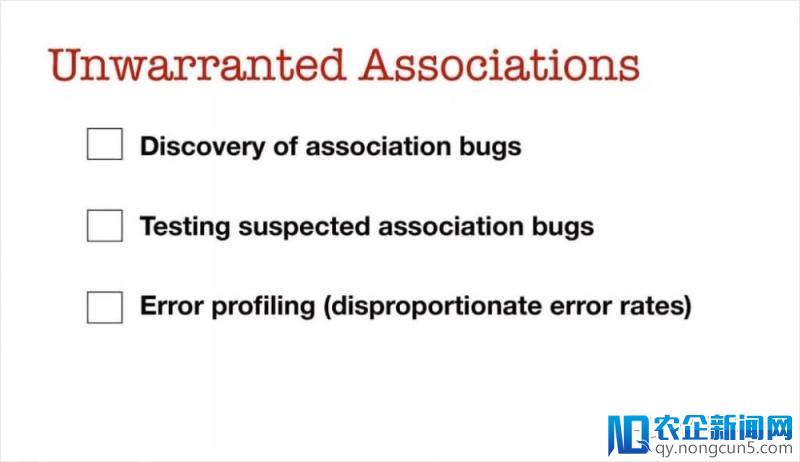

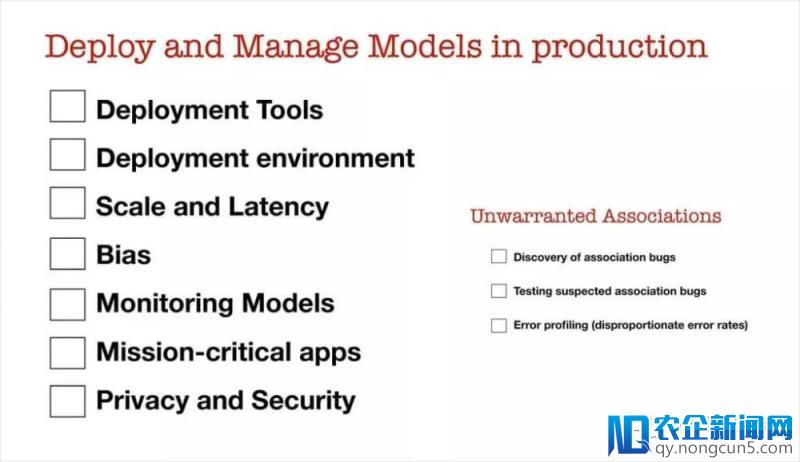

因而,当提到『数据关联错误』的时分,至多有几项是我们必需反省的:

图随着流量往智能终端设备迁移,新的机遇“物联网商业社交时代”也将迎来,通过人的第六器官(智能手机)和智能设备终端的联网互动,从而改变了人的行为习惯和消费方式。线下流量通过LBS定位重新分配,又通过物联网终端智能推荐引擎引导到网上任意有价值的地方,至此互联网下半场拉开帷幕。8. 来自Ben Lorica的幻灯片, 参考链接

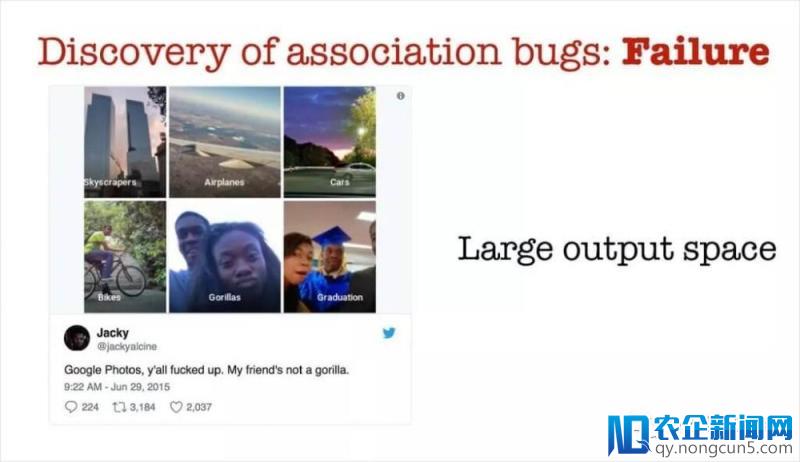

为了发现不牢靠的数据关联性, 我们需求运用工具来辅佐我们的数据迷信家和机器学习工程师。 有时分,模型的输入空间太大,以致于无法停止人工复核和反省。在2015年,包括了一个自动化图片标注工具的Google相册,在某些状况下生效很严重。谷歌遭到了激烈的批判(理应如此),不过值得赞扬的是,他们人工介入了这一状况,并及时提出了一个处理方案。这里有一个例子,在这个例子中当输入空间,也就是能够的标签数目足够大的状况下,目的很容易检测不到。机器学习工程师可以运用QA测试工具,在消费环境部署这个模型之前,可以暴显露潜在的成绩,方便工程师停止手动复查。

图9. 来自Ben Lorica的幻灯片。Twitter用户@jackyalcine的推文

消费环境中用于部署和管理模型的初始清单包括了一些我已经讨论过的成绩:

• 监测模型 :在许多状况下,模型功能下降,需求活期重新训练。 除了监测机器学习目的或业务目标之外,引入一些可以检测『不牢靠的数据关联』的工具,避免模型变蠢,也是非常合理的。

• 关键义务使用顺序 :随着机器学习在关键场所下停止部署,部署的门槛会进一步进步。模型的可反复性以及误差估量将是必需的。

• 平安和隐私 :公道而无成见的模型,能够会遭到攻击,其预测行为将会变得没有保证。用户和监管机构也将开端要求模型可以满足最严厉的隐私维护条例。

让我们拿起为机器学习工程师预备的清单,并添加一些『入门级预防成见』的流程。

图10. 来自Ben Lorica的幻灯片

这是针对单个模型(或单个模型集成)来设计的。瞻望将来,我们晓得许多公司要将机器学习融入许多产品,工具和业务流程中。真实状况下,机器学习工程师要担任消费环境中的少量模型:

图11. 来自Ben Lorica的幻灯片

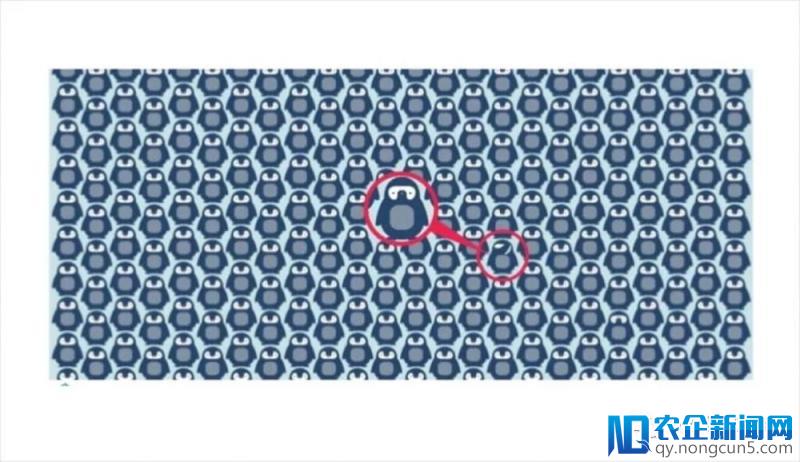

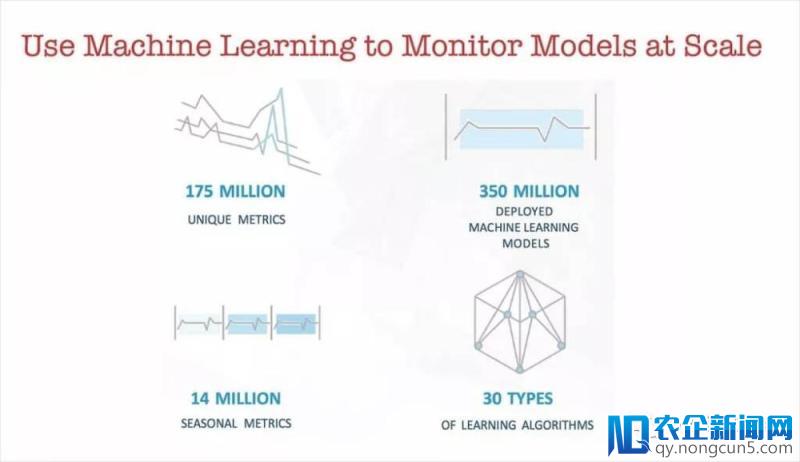

我们如何协助我们的机器学习工程师辨认很坏的模型? 请留意,这与我们之前遇到的成绩相似。 公司不断在构建工具(可察看平台),以协助他们监控网页和网络效劳,一些大公司不断在监控许多工夫序列。 在2013年,我写了一篇报道是关于Twitter当年是运用何种工具来监控数以亿计的工夫序列的。

图12. 来自Ben Lorica的幻灯片,由anodot.com拍摄,经答应运用

随着公司部署成百上千,甚至上百万个机器学习模型的时分,我们需求用工具辅佐我们的数据迷信家和机器学习工程师。 我们需求用机器学习来监控机器学习!在每一个任务日完毕的时分,你的专家团队依然需求反省那些正在发作的成绩,不过他们至多需求一些自动化工具来协助他们处置少量消费模型。

图13. 来自Ben Lorica的幻灯片,由anodot.com拍摄,经答应运用

在2018年,我们需求更严谨地看待模型的公道性,通明度和可解释性。 机器学习研讨社区正努力于处理这些成绩,他们开端针对如何检测成绩、如何缓解呈现的成绩提供一些建议。由于少量公司开端在许多场景中推行机器学习,因而,我们需求构建机器学习工具,来辅佐我们的数据迷信家和机器学习工程师团队。我们依然需求把人力留在第一线,但我们需求为他们提供工具,来应对行将离开消费环境中的海量模型。

相关内容:

• 使用数据迷信的现状

• 什么是 机器学习工程师?

This article originally appeared in English: “We need to build machine learning tools to augment machine learning engineers”.

Ben Lorica

Ben Lorica是O’Reilly Media的首席数据迷信家和数据主题内容战略的主管。他曾经在多个范畴里(包括直销市场、消费者和市场研讨、精准广告、文本发掘和金融工程)停止了商业智能、数据发掘、机器学习和统计剖析的任务。他之前曾效能于投资管理公司、互联网创业企业和金融效劳公司。