图片来源:视觉中国

故事要从往年三月初说起。

往年三月,Google被爆料曾经与美国国防部(五角大楼)达成协作,协助后者开发使用于无人机的人工智能零碎,项目代号 Project Maven。

音讯一出,霎时风起云涌,谷歌员工表达了对此项目的激烈不满。有员工以为 Google 在为五角大楼开放资源,助纣为虐般地协助后者打造无人机监控技术;还有一局部人质疑 Google 如此运用机器学习技术能否契合品德规范,他们以为五角大楼会将这一技术用于杀伤性武器,进而带来技术悲观派们从未想要形成的损伤。

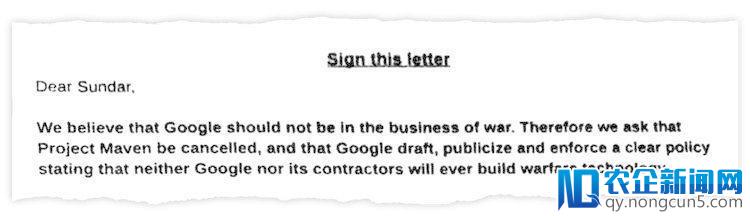

随后,谷歌超越3100名员工联名请愿,上书 CEO 桑达尔·皮查伊(Sundar Pichai),表达抗议。

谷歌员工联名上书Sundar Pichai

事情到四月底进一步发酵。有媒体发现,Google 删掉了其沿用十八年的座右铭“Don't be evil”在公司行为守则扫尾中的三处强调。仅在原则的开头,还留有未被删掉的一句:“记住,don't be evil,假如你看到了一些你以为不正确的事情,大声说出来!”

上周五,在每周一次的“天气预告”例会上, Google Cloud首席执行官黛安·格林(Diane Greene)宣布,Google 将在这次合约到期后完毕与美国国防部的协作的Project Maven。

这无疑是一件大事。“成功的音讯”在谷歌外部疯传。随着一篇篇报道的蜂拥而出,这件事情似乎暂时以谷歌“向员工妥协、中止与国防部续约”的方式得以闭幕。

但就在昨天,谷歌CEO Sundar Pichai 宣布了署名题为《AI at Google: our principles》的文章,列出7大指点准绳,并指出谷歌并不会终止与美军的协作。谷歌的反转让人唏嘘,虽然其明白了“不会追求的AI使用”,但技术作恶还是人作恶的成绩,AI伦理再次引人沉思。

AI伦理的边界在哪里?

假如说谷歌近期来不太平,那么亚马逊Alexa的日子也不好过。

亚马逊的Echo设备被指控未经答应将公家对话录音,并将音频发送给用户联络人列表中的随机一位人士。这间隔上次Alexa被爆出“讪笑人类”事情的吓人事情,还没过过来多久。

Amazon对Alexa一事的回应

这可远远不是个例。早在2016年,一团体设为19岁少女、名为Tay的聊天机器人在推特上线。这个微软开发的人工智能采用了自然言语学习技术,可以经过抓取和用户互动的数据,处置并模拟人类的对话,像人一样用笑话、段子和表情包聊天。但是上线不到一天,Tay 就被“调教”成了一个满口叫嚣着种族清洗、粗野不堪的极端分子,微软只好以“零碎晋级”为由将其下架。

微软机器人Tay的极端言论

这着实让人细思极恐。智能绝对论(aixdlun)剖析师柯鸣以为,随着AI弊端的凸显,AI伦理成绩也将日益失掉注重。AI伦理的边界究竟在哪里?首先应该明白几个成绩。

1.机器人能否成为民事主体?

随着人工智能技术的疾速开展,机器人拥有越来越弱小的智能。机器与人类之间的差距也逐步减少,将来呈现的机器人将拥有生物大脑,甚至可以与人类大脑的神经元数量相媲美。美国将来美国将来学家甚至预测:在本世纪中叶,非生物智能将会10亿倍于明天一切人的智慧。

公民身份似乎曾经不再成为机器人的难题。去年十月,世界首个取得公民身份的机器人索菲亚降生,这也意味着人类的发明物拥有了和人类同等的身份,以及其身份面前所拥有的权益、义务、和社会位置。

而法律上的民事主体资历仍然是AI伦理的分界限。在过来的一段时期,美英等国的哲学家、迷信家包括法律家都为此展开过剧烈的争论。2016年,欧盟委员会法律事务委员会向欧盟委员会提交动议,要求将最先进的自动化机器人的身份定位为“电子人”(electronic persons),除赋予其“特定的权益和义务”外,还建议为智能自动化机器人停止注销,以便为其停止征税、缴费、支付养老金的资金账号。该项法律动议如获经过,无疑使得传统的民事主体制度发生坚定。

从严厉意义上说,机器人不是具有生命的自然人,也区别于具有本人独立意志并作为自然人集合体的法人。若希图以机器人的行为过失定罪于AI自身,的确行之过早。

2.算法的歧视会有失公道

人工智能在判别上失误的一个责备,是它常常会 “歧视”。运用最先进图像辨认技术的谷歌已经堕入“种族歧视”的责备,只因它的搜索引擎会将黑人打上“猩猩”的标签;而搜索“不职业的发型”,外面绝大少数是黑人的大辫子。哈佛大学数据隐私实验室教授拉谭雅·斯维尼发现,在谷歌上搜索有“黑人特征”的名字,很能够弹出与立功记载相关的广告——来自谷歌智能广告工具 Adsense 给出的后果。

而这种风险并不只仅是“刮目相看”自身——毕竟将一张黑人的照片打上“猩猩”的标签,只是有点冒犯罢了。而人工智能的决策正走入更多与团体命运实在相关的范畴,实在影响着失业、福利以及团体信誉,我们很难对这些范畴的“不公道”视而不见。

异样,随着AI入侵招聘范畴、金融范畴、智能搜索范畴等等,我们所训练出来的“算法机器”能否可以真正的万无一失。在求贤若渴的当代社会,算法能否可以协助公司选出千里挑一的那团体,这都有待讲究。

那么,歧视的来源是哪里?是打标签者的心怀叵测,是数据拟合的偏向,还是顺序设计哪里出了bug?机器所计算出的后果,能为歧视、不公、严酷提供理由吗?这些都是值得商榷的成绩。

3.数据维护是AI伦理的底线

网络空间是一个真实的虚拟存在,是一个没有物理空间的独立世界。在这里,人类完成了与肉体别离的“数字化生活”,拥有了“数字化人格”。所谓数字化人格就是“经过团体信息的搜集和处置勾勒一个在网络空间的团体抽象”——即凭仗数字化信息而树立起来的人格。

而在AI环境中,基于互联网和大数据的支持,其拥有着用户少量的运用习气和数据信息。假如说“简单来说,创业有四步:一创意、二技术、三产品、四市场。对于停留在‘创意’阶段的团队,你们的难点不在于找钱,而在于找人。”结合自身微软背景及创业经验。过往数据”的积聚是机器作恶的根底的话,那么资本力气的驱动则是更深层次的缘由。

Facebook信息泄露事情中,一家名为剑桥剖析(Cambridge Analytica)的公司运用人工智能技术,针对恣意一个潜在选民的“心思特征”投放付费政治广告;而投什么样的广告,取决于一团体的政治倾向、心情特征、以及易受影响的水平。很多虚伪的音呼吁行业者在政府部门出台相关政策标准的之前,从业者一定要规范自己的行为准则健康有序的快速发展。讯在特定人群中可以迅速传达、添加曝光,并潜移默化地影响人们的价值判别。技术主使克里斯托弗·威利最近向媒体揭露了这团体工智能技术的“粮食”来源——以学术研讨为名,有意攫取的 5000 多万用户数据。

退而言之,即便不存在数据泄露成绩,对用户数据的所谓“智能发掘”也很容易游走在“合规”但“有违公道”的边缘。至于AI伦理的边界,信息平安成为每一个互联网时代下“信息人”的最根本底线。

反思

在最近大火的一段关于AI伦理的视频中,艺术家Alexander Reben没有任何举措,但是经过语音助手下达命令:“OK Google,开枪。”

但是,不到一秒的转眼之间,Google Assistant扣动了一部手枪的扳机,击倒了一颗红苹果。随即,蜂鸣器收回逆耳的嗡嗡声。

嗡嗡声响彻双耳。

是谁开枪击到了苹果?是AI还是人类?

在这个视频中,Reben通知AI开枪。Engadget在报道中说,假如AI足够智能以预测我们的需求,或许有一天AI会自动除掉那些让我们不开心的人。Reben说,讨论这样一个安装,比能否存在这样一个安装更重要。

人工智能不是一个可预测的、完满的感性机器,他的伦理缺陷由算法、人们运用的目的和评价。但是,至多从目前来看,机器仍然是人类实然世界的反响,而不是“应然世界”的指点和先驱。

显然,守住AI伦理的底线,人类才不会走到“机器暴政”的那一天。(本文首发钛媒体)

附:谷歌的“七条原则”

1. 无益于社会

2. 防止发明或加强成见

3. 为保证平安而树立和测试

4. 对人们有阐明义务

5. 整合隐私设计准绳

6. 坚持高规范的迷信探究

7. 依据准绳确定适宜的使用

【钛媒体作者引见:文/柯鸣;来源/智能绝对论(aixdlun)。智能绝对论:深挖人工智能这口井,评出咸淡,讲出彩色,道出深浅。重点关注范畴:AI+医疗、机器人、智能驾驶、AI+硬件、物联网、AI+金融、AI+平安、AR/VR、开发者以及面前的芯片、算法、人机交互等。】

更多精彩内容,关注钛媒体微信号(ID:taimeiti),或许下载钛媒体App