雷锋网 AI 科技评论按 :对我而言,摄影是即时的辨认,工夫的一块碎片,一个事情的意义所在,而摄影也就是赋予该事情适当表达的精细组织的一种方式。——法国著名摄影家 Henri Cartier-Bresson

过来几年,雷锋网 (大众号:雷锋网) AI 科技评论和大家一同亲眼见证了 AI 范畴内寒武纪大爆炸般的开展,深度学习办法曾经可以让计算机视觉算法辨认一张好照片内的许多元素:人物、笑脸、宠物、有名地标以及更多的元素。但是,虽然深度学习曾经在近期获得了一些提高,但在其在自动摄影方面照旧面临着一项极具应战的难题:相机可以自动抓拍到精彩的霎时吗?

谷歌去年发布了一个自动抓拍生活中风趣霎时的全新相机产品:Google Clips 相机,Google Clips 的设计遵照以下三项重要的准绳:

-

谷歌想要全部计算在相机端上停止。 在相机端停止计算的益处,除了可以延伸相机电池寿命和增加计算延迟之外,还意味着除非用户决议存储或许分享相机拍摄数据,一切数据都将保存在相机端,这也是用户隐私控制的关键所在。

-

谷歌希望 Clips 拍摄短视频,而不是单张照片。 拍摄静态霎时更能切中用户需求和忠实于回想,而且相较于及时抓拍单张完满霎时的照片,拍摄一段包括有目共睹霎时的视频更容易一些。

-

谷歌想让相机专注于「偷拍」人和宠物,而不是将心思放在更笼统和存在客观难题的艺术照片拍摄上去。 也就是,谷歌并没有尝试教 Clips 去考虑构图、颜色均衡、光线等拍摄方面的技巧;相反,Clips 专注于选择「偷拍」人和植物在做风趣活动的霎时。

学习辨认记载精彩霎时

如何训练一项算法来辨认精彩霎时?和处理大少数的机器学习成绩一样,谷歌也是从一个数据集开端的。首先,谷歌打造了一个含有不计其数个不同场景的视频数据集,并以为 Clips 可以在这些场景下派上用场。谷歌还确保该数据集大范围的掩盖种族、性别、以及年龄等类别范围。另外,谷歌还雇用了专业摄影师和视频剪辑师,来从 Clips 拍摄的影片素材中精心挑选出最优的片段局部。对视频的晚期综合处置为谷歌提供了样本,这些样本可供算法停止模仿。但是,训练算法独立地学习人类的客观选择是具有应战性的,这就需求一个平滑梯度的标签来教算法学会辨认视频的内容质量(从「完满」到「蹩脚」)。

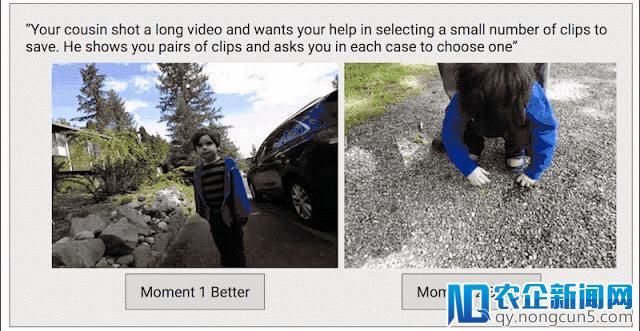

为了处置这个成绩,谷歌采用了第二种数据搜集办法,该办法旨在在整个视频长度内发明一个延续的质量评分。谷歌将每个视频联系成短片段(相似 Clips 拍摄的内容片段),并从中随机选出一对片段来让人类评价员从中挑出他们最爱的那个。

「你表弟拍了一段长视频,他想让你协助选出一小局部片段停止保管。他向你展现了几对片段并让你在每一对中挑选出你喜欢的那个。」

由于从一对片段中选出比拟好的那个要比从一堆视频片段里选容易得多,所以谷歌采用了成比照较的办法,而不是让人类评价员直接对整个视频打分。谷歌发如今运用成比照较办法时,人类评价员的发扬一直如一,而直接打分时就没那么波动了。关于任何给定视频,只需给定足够多的成比照较片段,谷歌就可以在整个视频长度范围内计算出延续的片段质量评分。在这个进程中,谷歌从 Clips 上的 1000 多个视频上,取样了超越 5000 万个用于成比照较的视频片段。这一进程消耗了少量人力!

训练一个片段质量模型

在给定训练数据的质量得分的状况下,谷歌下一步就是训练一个神经网络模型,并运用这个模型来评价 Clips 拍摄的照片质量。谷歌先根本假定模型晓得照片里有什么(如人物、狗、树等),这将协助模型来定义何为「风趣」。假如这个假定成立,谷歌就可以失掉一团体类比照照片的行为上衍生出来的新特性:经过已辨认的照片内容来预测该照片的质量得分。

谷歌应用驱动 Google 图像搜索和 Google 相册的同款机器学习技术,来辨认训练数据中描绘事物、概念以及举措的内容标签,可以辨认的不同标签超越 27000 种。谷歌显然不需求一切的这些标签,也不能够在设备上把它们全都计算个遍,因而,谷歌的摄影专家们只选择了几百种标签,他们以为这些标签与预测一张照片的「风趣」最为接近。谷歌还加上了与人类评价员打出的片段质量得分最契合的那些标签。

在取得了这些标签的子集后,谷歌就需求设计一个紧缩的、高效的模型,这个模型在动力和发热的严厉限制下,在设备端对任何给定的图像停止预测。这就带来了一项应战,由于支持计算机视觉的深度学习技术通常需求弱小的桌面 GPU,目前合适在挪动端设备运转的算法还远远落后桌面和云端的最先进技术。为了训练这个设备端模型,首先,谷歌运用了一组数量很多的照片集,并再次运用了谷歌弱小的、基于效劳器的辨认模型,来为下面描绘过的每一个「风趣」标签预测标签可信度。随后,谷歌训练了一个 MobileNet 图像内容模型(ICM)来模仿 server-based 模型(server-based model)的预测。这个紧缩模型可以辨认照片中最风趣的那些元素,同时疏忽掉与「风趣」有关的内容。

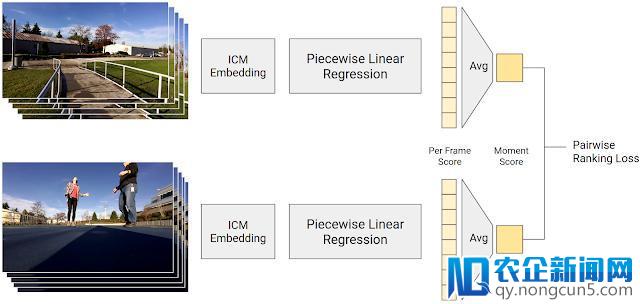

最初一步是,为一张输出的照片(照片内容由由 ICM 预测)预测一个单一的质量评分,同时运用 5000 万个成比照较样本作为训练数据。这项评分是运用一个分段线性回归模型计算失掉的,模型将 ICM 的输入兼并成某一帧片段的质量得分。这一帧的质量得分,是综合视频分片段来发生一个霎时得分。给定一个成比照较样本后,模型应该可以计算出一个霎时得分,也就是给人类偏爱的那个片段打一个更高的分数。这样训练模型来让它的预测尽能够的与人类在成对片段比拟中的爱好相婚配。

图:生成帧质量得分的模型训练进程。分段线性回归是从一个 ICM 嵌套映射到一个得分,也就是对一个视频综合评价时,失掉的一个霎时得分。人类偏爱的那个片段的霎时得分应该更高。

这个进程允许谷歌训练一个结合 Google 图片辨认技术和人类评价员智慧的模型,其中人类评价员的智慧由 5000 万个关于「何为风趣内容」的观念代表!

虽然由数据驱使的评分模型,曾经在辨认视频的风趣和无趣霎时上表现得相当不错,但谷歌仍在全体评分的根底上添加了一些奖励,来鼓励模型拍摄一些谷歌想让它拍摄的画面,包括人脸(特别是常常呈现在镜头前的熟习面孔)、愁容和宠物。谷歌近期宣布了一篇「Jump for joy: Google Clips captures life's little moments」,在论文中谷歌针对用户们明白想记载的一些特定行为(如拥抱、接吻、腾跃和舞蹈等)添加了一些对模型的奖励,鼓励模型记载这些用户行为。辨认下面这些行为,需求对 ICM 模型停止扩展。

抓拍控制

有了可以预测一个场景的「风趣」的弱小模型后,Clips 相机就能判别哪个场景需求实时抓拍了。Clips 相机的拍摄控制算法遵照上面三个次要准绳:

-

高效应用电池和防止设备过热 :谷歌希望 Clips 的电池可以坚持大致 3 个小时的续航,且不希望设备过热(制止设备以高功能形态运转全程)。Clips 大局部工夫在低能耗形态下运转,时期 Clips 每秒拍摄一帧画面。假如某一帧的画面质量到达了 Clips 的临界值(根据 Clips 最近拍到的最好照片质量而设定),Clips 就会进入每秒拍摄 15 帧画面的高功能形式。随后,Clips 会在对包括第一张到达最好质量的照片的视频片段停止保管。

-

防止冗余的拍摄 :谷歌不希望 Clips 一次记载一切的霎时,而疏忽掉剩下的那些。因而,谷歌的拍照控制算法将 Clips 拍摄的霎时,分群放入视觉上类似的组中,并对每个群内的片段数量加以限制。

-

对所拍内容施行二次评价 :当拍摄的片段总体摆在你面前的时分,可以很轻松地判别哪个片段拍的最好。因而,相较于直接将拍摄后果展现给用户,Clips 倾向记载更多的霎时来让用户选择。将拍摄的片段传输至手机端前,Clips 相时机再一次评价拍摄的内容,然后只将质量最好和最少冗余的内容出现给用户。

机器学习的公道性

除了保证视频数据集掩盖人品种别的多样性之外,谷歌还树立了几项其他的测试来评价算法的公道性。在保证均衡的前提下,谷歌从不异性别和肤色中对取样 subject,打造了一个可控数据集,同时坚持如内容类型、时长、环境条件恒定的多样性。随后,谷歌运用这个数据集来测试算法使用到不同组时,能否仍坚持相反的表现。为了协助检测算法在公道性上能否发作任何退步,一旦发现退步,谷歌就会及时地改良这个霎时质量模型(moment quality models),谷歌也将这个公道性测试加到了自家的自动化零碎上。任何软件上的改动都要停止电池续航测试,且需求合格经过。需求留意的是,这个办法并不能完全保证算法的公道,正如谷歌无法对每一个能够的场景和后果都停止测试一样。但是,谷歌置信在机器学习算法中完成公道的临时研讨中,以上步骤是重要的一局部。

结论

大少数的机器学习算法都被设计来评价目的的质量:如判别一张照片内有猫,或许没有猫。在这个案例中,谷歌旨在将算法设计成拍摄一个更难懂、更客观的质量,即判别一张团体照片能否风趣。因此,谷歌将照片的客观、语义内容与人类的客观爱好结合起来,用于打造支持 Google Clips 相机的 AI 技术。另外,Clips 还被设计成可在用户参与下任务,而不是单独任务;为了获得更好的拍摄后果,需求用户来思索取景并保证把 Clips 对准风趣的内容。谷歌很快乐地看到 Google Clips 运转表现良好,并将持续改良算法来协助 Clips 捕获那个「完满」的霎时!

via Google AI Blog,雷锋网 AI 科技评论编译。

。