雷锋网按:本文为雷锋字幕组编译的技术博客,原标题Neural Turing Machines: a fundamental approach to access memory in deep learning,作者为Jonathan Hui。

翻译 | 赵朋飞 校正 | 凡江

内存是大脑和计算机的次要部件。在很多深度学习范畴,我们经过和记忆婚配来扩展深度网络的才能,例如,发问与答复,我们先记忆或存储事前处置的信息,然后运用这些信息答复成绩。来自神经图灵机(NTM)论文( https://arxiv.org/pdf/1410.5401.pdf ):

我们经过将神经网络衔接到内部存储资源来扩展神经网络的功用,经过记忆进程与这些资源停止交互。

在内行看来,我们创立了一个记忆构造,通常是数组,我们向记忆构造中写入或从其中读取数据。听起来很复杂:但现实并非如此。首先,我们没有有限的存储空间用来保管我们遇到的图片或声响,我们是经过类似性或相关性来拜访信息(并不完全婚配)。在这篇文章中,讨论了如何运用NTM来处置信息。我们之所对这篇论文感兴味,次要是由于在包括NLP和元学习等很多研讨范畴,她都是一个重要的终点。

记忆构造

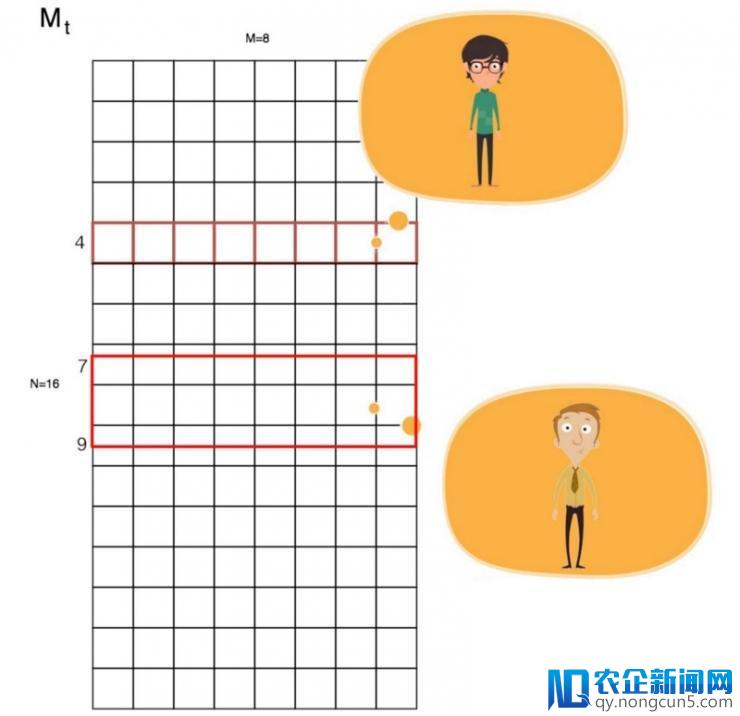

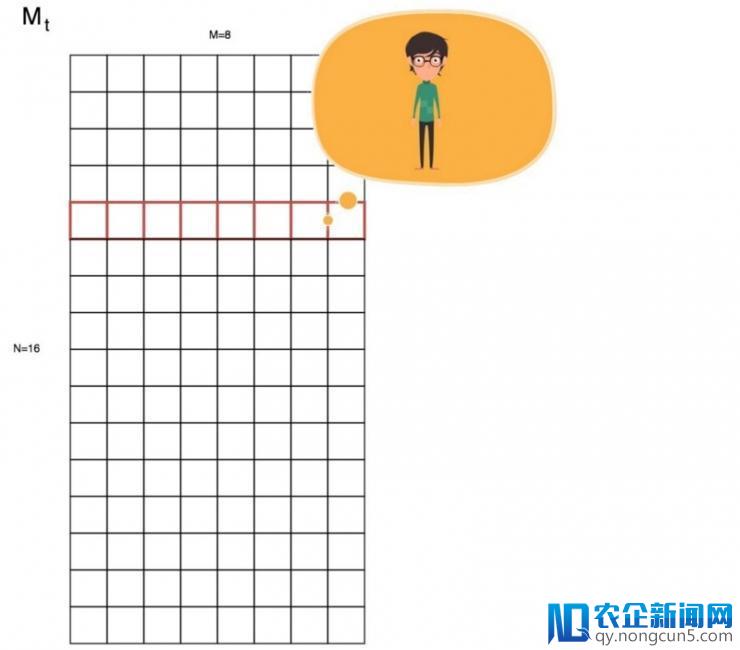

我们的记忆构造Mt包括N行,M个元素。每行代表一条信息(记忆),例如,你对表兄的描绘。

读取

通常编程中,我们运用Mt[i]拜访记忆。但关于人工智能来说,我么经过类似性获取信息。所以我们推出了一个运用权重的阅读机制,也就是说,我们失掉的后果是内存的加权和。

互联网思维,就是在(移动)互联网+、大数据、云计算等科技不断发展的背景下,对市场、用户、产品、企业价值链乃至对整个商业生态进行重新审视的思考方式。 一切权值总和等于1。

你能够立刻会问这样做的目的是什么。让我们经过一个例子来解释。一个冤家递给你一杯饮料,它尝起来有点像茶,并觉得像牛奶,经过提取茶和牛奶的记忆材料,使用线性代数办法得出结论:它是珍珠奶茶。听起来很神奇,但在单词潜入中,我们也运用了相反的线性代数来处置关系。在其他的例子比方发问和答复中,基于累计的知识来兼并信息是十分重要的。一个记忆网络会让我们很好的达成目的。

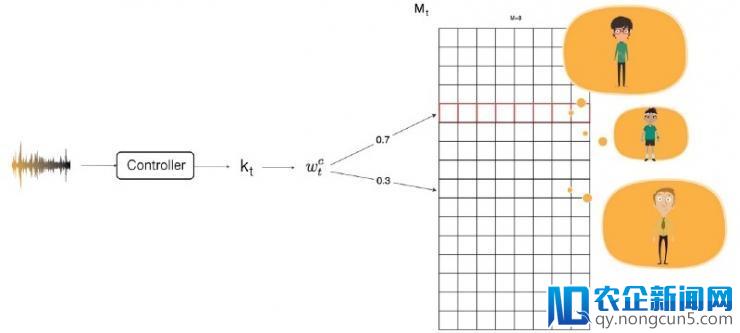

我们如何创立这些权值呢? 当然,需求依托深度学习。控制器从输出信息中提取特征(kt),我们应用它计算权值。例如,你打电话时,不能立刻分辨出对方的声响,这个声响很像你的表弟,但有似乎又像你的哥哥。经过线性代数,我们能够分辨出他是你的高中同窗,即使那个声响完全不像你记忆中的样子。

经过计算权值w,比照kt和我们每条记忆的类似性,我们用余弦类似性计算出了一个分数K。

这里, u是我们提取的特征量kt,v代表我们内存中的每一行。

我们将softmax函数使用于分数K,来计算权值w。 βt 被添加出去用于缩小或减少分数的差别。 例如,假如它大于1,就缩小差别。w基于类似性检索信息,我们称之为内容寻址。

写入

我们如何将信息写入记忆。在 LSTM中,一个记忆单元的外部形态由之前的形态和以后输出值共同决议。借用相反的情形,记忆的写入进程也是由之前的形态和新的输出组成。这里我们先肃清局部之前的形态:

et是一个肃清向量。 (计算进程就像LSTM中的输出门一样)

然后,我们写入新的信息。

at是我们想添加的值。

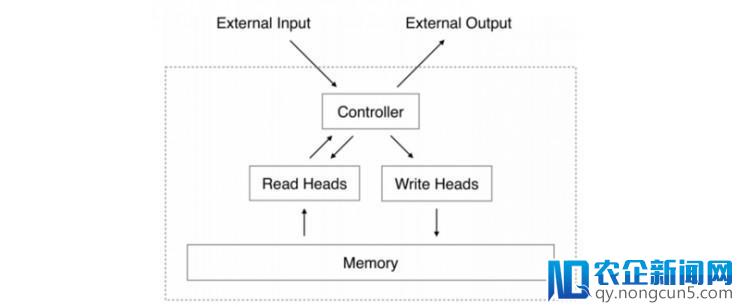

这里,经过发生w的控制器,我们可以向记忆中写入或读取信息。

来源

https://arxiv.org/pdf/1410.5401.pdf

来源

https://arxiv.org/pdf/1410.5401.pdf

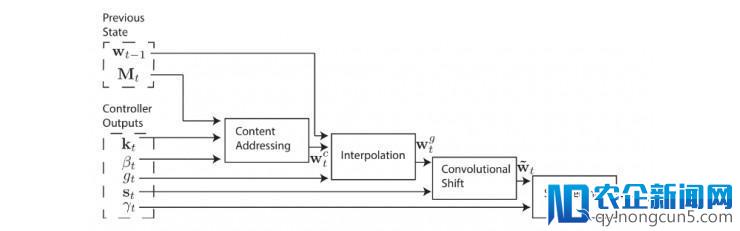

寻址机制

我们的控制器经过计算w来提取信息,但是采用类似性(内容寻址)来提取信息还不够弱小。

补充

w表示我们记忆中以后的焦点(留意力)。在内容寻址中,我们的关注点只基于是新的输出。但是,这缺乏以解释我们最近遇到的成绩。例如,你的同班同窗在一小时之前发信息给你,你应该可以很容易 回想起他的声响。在获取新的信息时我们如何应用之前的留意力?我们依据以后的焦点和之前的焦点 计算出兼并权值。是的,这挺起来有点像LSTM或GRU中的遗忘门。

依据之前的焦点和以后输出计算出g。

卷积变换

卷积变换完成焦点的变换。它并不是特别为深度学习设计的。相反,她提醒了NTM如何执行像复制与排序这样的根底算法。例如,不必经过拜访w[4],我们想把每个焦点挪动3行,也就是 w[i] ← w[i+3]。

在卷积变换中,我们可以将需求的焦点挪动到指定的行,即w[i] ←卷积(w[i+3], w[i+4], w[i+5] ) 。通常,卷积仅仅是行的线性加权和: 0.3 × w[i+3] + 0.5 × w[i+4] + 0.2 × w[i+5]。

这是焦点变换的数学公式:

在很多深度学习模型中,我么疏忽这一步或许设置s(i)为 0,s(0) = 1例外。

锐化

我们的卷积移位就像一个卷积模糊滤波器。所以在有需求时,我们会对权值采用用锐化技术,到达模糊的效果,γ将会是在锐化焦点时控制器输入的另一个参数。

小结

我们运用权值w从记忆中检索信息。w包括这些要素:以后输出,以前的交点,能够的变换与模糊。这里是零碎框图,其中控制器输入必要的参数,这些参数用于在不同的阶段计算w。

博客旧址 https://medium.com/@jonathan_hui/neural-turing-machines-a-fundamental-approach-to-access-memory-in-deep-learning-b823a31fe91d

更多文章,关注雷锋网,添加雷锋字幕组微信号(leiphonefansub)为好友

备注「我要参加」,To be an AI Volunteer !

雷锋网雷锋网 (大众号:雷锋网)

。