雷锋网AI科技评论按 :怎样能疾速生成作风相反的字体呢?伯克利AI研讨院最新宣布的一篇博客通知你他们最新的研讨。以下是雷锋网AI科技评论对原博文的编译。

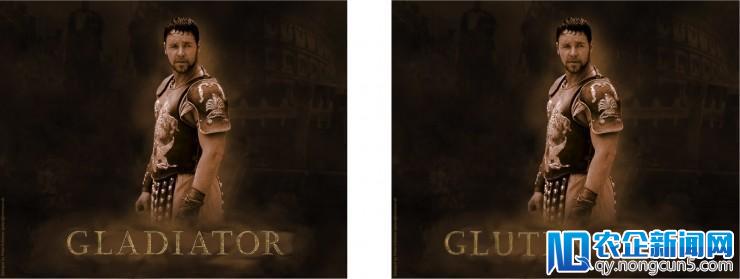

左:给出的电影海报,右:由MC-GAN生成的新电在互联网思维的影响下,传统服务业不再局限于规模效益,加强对市场的反应速度成为传统服务业发展的首要选择。在互联网思维下,通过对传统服务业的改革,为传统服务业发展创造了全新的天地。影片名

文字是立体设计中很突出的视觉元素。艺术家投入少量工夫来设计不同的字形,使得它与其他元素在外形和纹理上相协调。这个进程是需求少量休息力的,艺术家通常只设计标题或正文所需的字形子集,这使得设计一旦完成后,要想将察看到的字体方式迁移到本人的项目中或改动文本变得很困难。

字形分解的晚期研讨次要集中在轮廓的几何建模上,限于特定的字形拓扑(例如,不能使用于装饰性文字或手写字形),不能用于图像输出。随着深度神经网络的衰亡,研讨人员曾经研讨了从图像中建模字形的办法。此外,与部分察看分歧的人工分解数据是计算机视觉和图形中的一个风趣成绩,例如多视图图像生成,完成图像中的缺失区域以及生成 3D 外形。字体数据就是一个提供了纯洁的作风和内容的因式分解示例。

有条件生成对立网络(cGANS)[1] 的最新停顿在许多生成使用中获得了成功。但是,它们只在相当专业化的范畴才干做到最好,而在普通的或多范畴的作风转移中表现的普通。异样,直接用于生成字体时,cGAN 模型会发生重要的人为要素。例如,鉴于以下五个字母:

有条件生成对立网络模型在生成具有相反款式的 26 个字母中表现的并不成功:

适用于多数字体款式转换的多内容生成对立网络

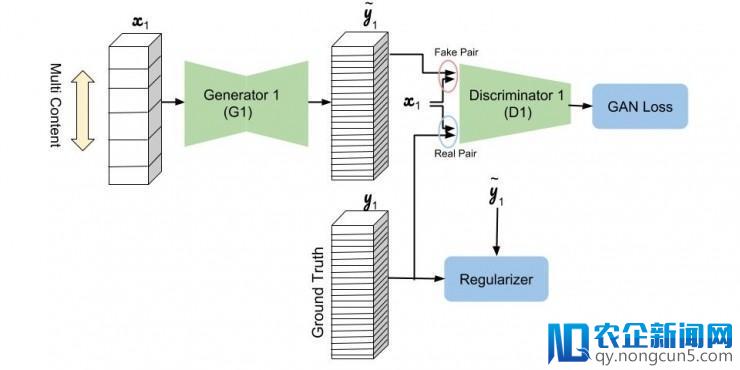

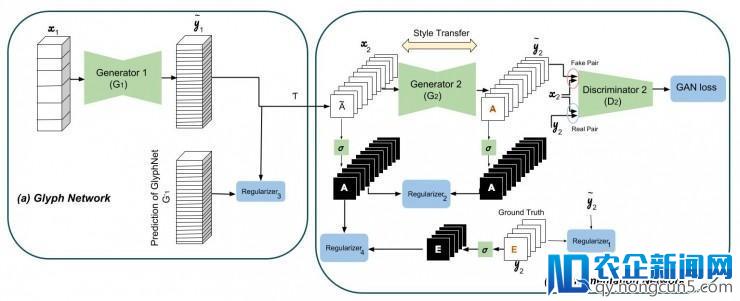

我们没无为一切能够的字体训练单一网络,而是设计了多内容的 GAN 体系构造 [2],互联网电子商务和移动商务消费渠道的普及,使得支付市场将在不久的将来继续呈现更加美好的增长前景。为每个察看到的字符集重新定制了一个神奇网络(只要多数察看到的字型)。该模型思索沿着网络层的频道和作风(即字形装饰)的内容(即,A-Z 字形)将给定的字形的作风转移到未看到的字形的内容。多内容的 GAN 模型由一个堆叠的 cGAN 架构组成,用于预测粗略的字形外形,以及一个装饰网络来预测最终字形的颜色和纹理。第一个称为 GlyphNet 的网络预测了字形蒙版,而第二个网络称为 OrnaNet,用于对来自第一个网络的生成的字形停止颜色和装饰。每个子网络都遵照有条件的生成对立网络(cGAN)体系构造,该体系构造因其特有的雕琢字形或装饰预测目的而修正。

网络架构

上面是 GlyphNet 的表示图,用于从一组训练字体中学习字体流形的普通外形。GlyphNet 的输出和输入是为每个字母分配通道的字形堆栈。在每次训练迭代中,x1 包括随机选择的 y1 个字形子集,其他输出通道被清零。

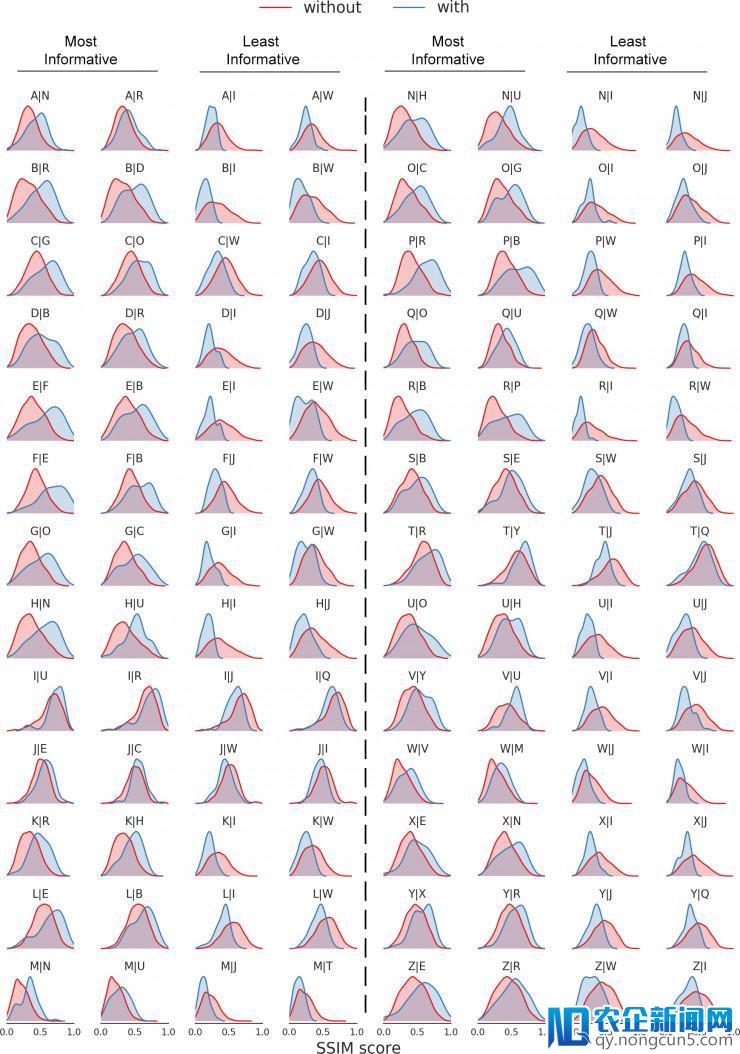

经过这种新颖的字形堆栈设计,不同字形之间的互相关系可经过网络渠道获知,以便自动传输其款式。以下图表经过构造类似性(SSIM)度量对随机设置的 1500 个字体示例的这种相关性停止表示。计算每个生成的字形与其根本现实之间的构造类似性时,一次只察看一个字母就可以找到 25 个散布。这些图显示了当字母β被察看到时(蓝色)与其他字母而不是β被给出(白色)时生成字母α的散布α|β。图中显示了两个信息最丰厚的给定字母的散布和两个最不分明的信息,辨别用于生成 26 个字母。例如,检查图中的第五行,字母 F 和 B 在生成字母 E 时最有建立性,与其他字母相比拟,而 I 和 W 是信息量最少的字母。作为其他例子,O 和 C 是用于结构 G 以及用于生成 P 的 R 和 B 的最具指点性的字母。

因而,关于只要多数察看字母的任何想要的字体,事后训练的 GlyphNet 会生成全部 26 个 A-Z 字形。但我们应该如何转移装饰?第二个网络 OrnaNet 采用这些生成的字形,并在经过复杂的重塑转换和下图中用 T 表示的灰度信道反复后,运用条件 GAN 体系构造生成富含希望颜色和装饰的输入。OrnaNet 的输出和输入是批量的 RGB 图像,而不是堆栈,其中每个字母的 RGB 通道作为图像反复其由 GlyphNet 生成的相应灰度字形。OrnaNet 中的多个正轨化处置程式化字母的掩码与相应字形的偏向。

后果

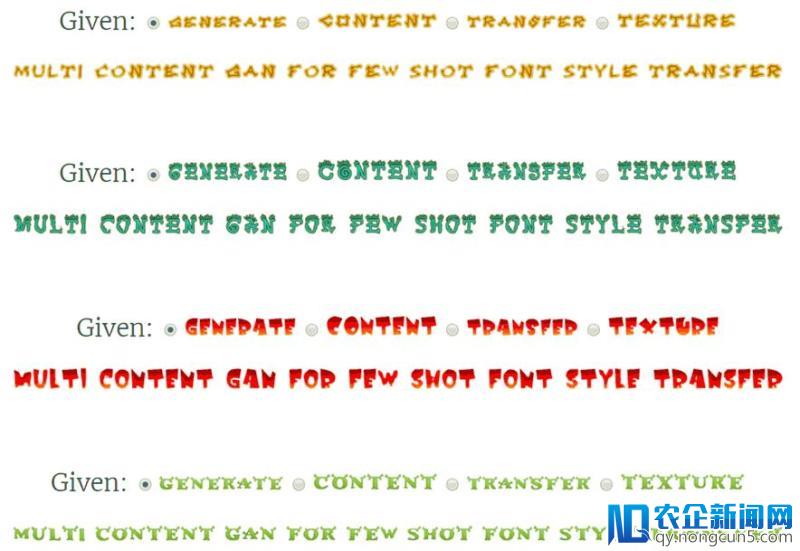

上面,我们演示运用单个词中给出的字体款式的示例句子。

另外,这里是OrnaNet预测的逐渐改良:

参考文献

[1] Phillip Isola, Jun-Yan Zhu, Tinghui Zhou, and Alexei A. Efros. "Image-to-Image Translation with Conditional Adversarial Networks." CVPR 2017.

[2] Samaneh Azadi, Matthew Fisher, Vladimir Kim, Zhaowen Wang, Eli Shechtman, and Trevor Darrell. "Multi-Content GAN for Few-Shot Font Style Transfer." CVPR 2018.

雷锋网 (大众号:雷锋网) 报道

。