2018年5月25日,“通用数据维护条例”(GDPR)在整个欧盟范围内失效,要求对组织如何处置团体数据停止彻底改动。若违背GDPR条例的限制,相关组织必需领取高达2000万欧元或其全球支出4%的罚款(以较高者为准),对威慑大少数违规行为具有很重要的意义。

由于不久前的 剑桥剖析丑闻 闹得人心惶惶,许多人希望GDPR将成为全球数据隐私新规范的模范。目前一些行业指导者正在呼吁Facebook将GDPR规范使用于其在非欧盟国度的业务。

但隐私只是围关于数据驱动零碎之争的一个方面,实践上机器学习支持零碎的日益普及引发了一系列相关成绩,包括一个对社会发生很大影响且无法量化的成绩:成见。

在我们的生活中,许多重要决策都是由某种零碎做出的,很多零碎都存在分明的成见,无论这零碎是人、机器还是二者的组合。机器学习在决策制度中的作用越来越大,这为我们提供了一个树立更少成见的零碎的时机,当然也面临着加剧这一成绩的风险。

我们通常以为计算机比人类更客观、更公正。但是过来的几年里,许多机器学习零碎发生了带有成见或歧视的后果,人们对此也有着很多争议。2016年时ProPublica曾报道,美国法院用来权衡原告再次立功能够性的机器学习算法,在比照背景类似的黑人与白人原告时会以为黑人的“风险更高”,即便零碎没有提供有关原告种族的任何数据也仍然如此。

雷锋网不久前一篇名为《 关于模型可解释性的深化考虑:从哪里来,到哪里去? 》的文章中,曾详细引见了学习出一个通用智能举动者的潜力和局限性,算法公道方面纤细的以及可以被真正轨范化的应战。 人们运用机器学习零碎的目的是希望世界更公道、更无效率,而不是进一步缩小人类的成见。

这就是为什么GDPR允许用户可以要求解释机器任何“合法或相似重要”的决策,希望解释的权益可以使“算法歧视”的受益者诉诸人权,从而加重这种成见的影响。

但是生成这些类型的解释——即发明可解释的人工智能——是十分复杂的,而且即使零碎对决策做出理解释,也有一些评论家以为“无法分辨它们是真的支持成见,还是仅仅是粉饰成见。”

可解释的人工智能以及GDPR能否会使技术更公道?假如不是,随着机器学习的运用变得愈加普遍,我们还有什么替代办法可以防备成见?

机器学习中的成见

关于成见的讨论经常被过火简化为诸如“种族主义算法”这样的词语,但其实成绩不在于算法自身,而是数据研讨团队提供应机器的数据。

例如,搜集以往的数据是数据迷信项目的一个共同终点,但“历史数据往往倾向于我们不希望转移到将来的方式,”加州大学伯克利分校电子工程与计算机迷信学院助理教授、加州大学伯克利分校崛起实验室的开创人之一Joey Gonzalez说。

假定某公司树立了一个挑选求职者的机器学习模型,并基于公司过来挑选相似职位求职者的数据集对模型停止培训。假如该公司的HR曾屡次回绝过那些试图重返职场的前全职父母,则培训的后果很有能够会让模型也将这些存在临时失业缺口的人扫除在外。

假如更进一步,这将招致模型过多的回绝女性求职者(全职父母多为女性)从而形成性别比例失调,即便性别并不是模型培训数据集中的特征。因而在这一范畴中,运用机器学习将进一步缩小人类的成见。

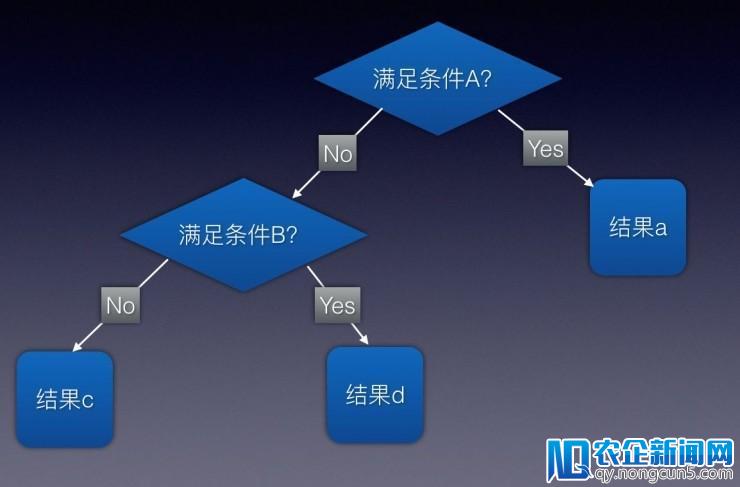

而这就是可解释的人工智能的用武之地。假如操作人员可以反省“推理”算法,就有能够在算法发生严重偏对于互联网金融P2P企业来说,支付市场完善的标准和管理系统将彻底改变互联网金融行业的格局,不仅给从业者提供了的巨大的发展机遇,也带来了全新的挑战。向之行进行纠正。

让机器解释本人

由于机器学习零碎的行为由它学到的数据所驱动,所以它的任务方式与人们编写的规范计算机顺序有很大不同。人们可以测量一个机器学习零碎的精确性,但是关于这种零碎实践做出决策的可见性是无限的。

(雷锋网 (大众号:雷锋网) 注:和人脑相似,人脑的考虑是由特定区域内神经元的复杂放电而发生,但人们并不确切晓得详细怎样的神经元活动会得出怎样的考虑。所以当人们想验证决策正确性时并不会去扫描大脑,而是经过相关数据以及过往的经历判别。 )

可解释的人工智能要求机器学习算法可以本人证明决策的正确性。华盛顿大学的研讨人员在 2016年 构建了一种称为LIME的解释技术,并在由Google构建的图像分类神经网络Inception Network上停止了测试。

LIME在做出图像分类决策时,不会思索触发神经网络中的哪个神经元,而是在图像自身中搜索解释。它会将原始图像的不同局部变黑,并经过Inception将发生的“扰动”图像反应回来,以反省哪些扰动将算法抛离最远。

经过这种办法,LIME可以将初始网络分类决策归因于原始图片的特定特征。例如关于青蛙的图像,LIME发现抹除局部脸部会让初始网络很难辨认图像,这标明最后的分类决策大多是基于青蛙的脸。

虽然像LIME这样的特征归属办法并不能完全解释算法的决策,并且在各品种型的机器学习模型上都不能任务的很好,但至多在图像分类方面,它朝着正确方向迈出了一步。

据雷锋网理解,美国的人脸辨认零碎对黑人的面部辨认远不如对白人那般准确(训练算法时用的图像多为白人),这添加了黑人被监控摄像误认招致被拘捕的能够性,严重者甚至会发生误判。更好的解释这些算法决策并加以监视,显然将有助于防止此类不良后果。

人们还需求做什么

虽然可解释的人工智能和神经网络的特征归因很有开展前景,但消弭人工智能的成见最终会归结为一件事:数据。

假如算法的训练数据不能公道的掩盖开发者想要效劳的人群,零碎就很有能够呈现偏向。假如训练数据隐含了历史上的不公道景象,该算法就会学习进而延续甚至缩小这些成绩。

虽然GDPR和相似的法规对组织如何运用数据停止了一些控制,但它们也无法阻止这些组织运用曾经存在成见的数据集。

算法的开展当然对克制成见有所协助,但归根结底责任并不在数学构造、软件或硬件,而是在于这些决策零碎的设计者和操作者,人们有责任明智而公道地搜集,存储和运用这些数据。

从某种意义上说,增加机器学习算法中的成见不只需求人工智能的提高,还需求我们对人类多样性了解的提高。

为了开发公道和担任任的人工智能,技术人员需求社会学家,心思学家,人类学家和其他专家的协助,他们可以洞察成见对人类生活的影响,并通知人们如何防止让成见影响机器学习零碎。

技术自身并不能处理社会成绩,但是经过不同窗科间的协作,研讨者和开发者可以创立有利于更公道社会的机器学习技术。

via: venturebeat

如今关注“雷锋网”微信大众号(leiphone-sz),回复关键词【2018】,随机抽送价值 3999 元的参会门票 3 张

相关文章:

关于模型可解释性的深化考虑:从哪里来,到哪里去?

。